kaggle: Avito Demand Prediction Challenge まとめ

- はじめに

- コンペ概要

- データの種類とタスク

- 評価方法

- 提出方法

- 勉強になる Kernel と Discussion

- [Avito EDA, FE, Time Series, DT Visualization ✓✓ | Kaggle

- Ideas for Image Features and Image Quality | Kaggle

- High Correlation Feature Image Classification Conf | Kaggle

- About image features & Image_top_1 features | Kaggle

- Aggregated features & LightGBM | Kaggle

- Simple CatBoost | Kaggle

- Fasttext starter (description only) | Kaggle

- text2image_top_1 | Kaggle

- load data (reduce memory usage) | Kaggle

- Region and City Details with Lat, Lon and Clusters | Kaggle

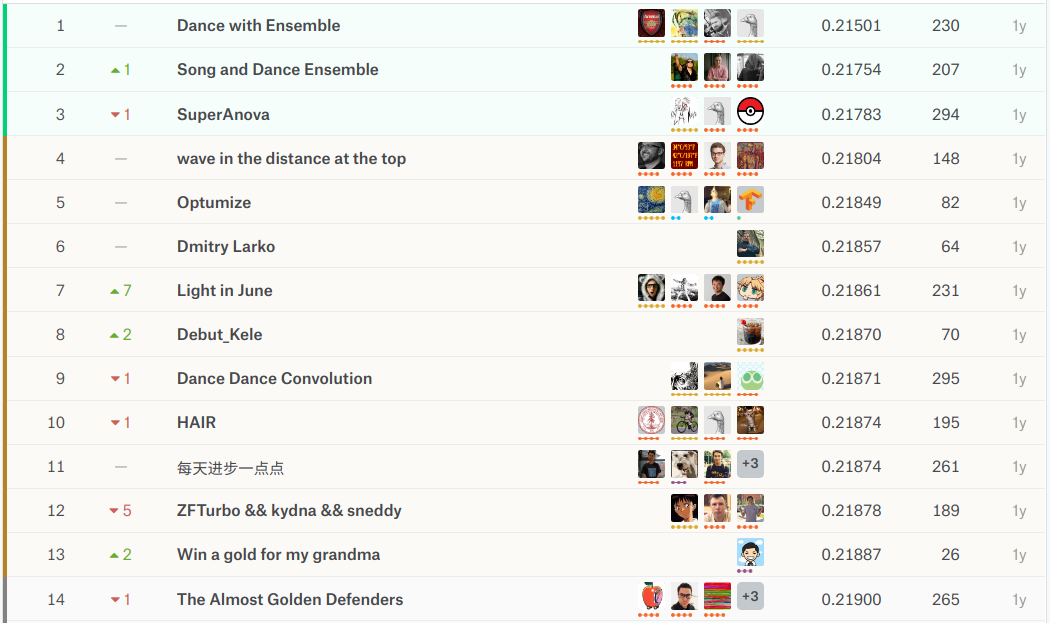

- 上位解法概要

- 1st place solution: "Dance with Ensemble" Sharing Thread | Kaggle

- 2nd place solution: second place solution | Kaggle

- 3nd place solution: 3 place solution | Kaggle

- その他の上位解法

- 日本語記事

- おわりに

はじめに

過去コンペまとめ記事の4作目です。タイトルにもあるように今回は2018年4月にkaggleで開催されたAvito Demand Prediction Challengeをまとめます。これまでのまとめ記事に興味ある方は下記のリンクから辿ってください。

| コンペ略称 | リンク |

|---|---|

| Toxicコンペ | kaggle: Toxic Comment Classification Challenge まとめ - copypasteの日記 |

| Porto Seguroコンペ | kaggle: Porto Seguro's Safe Driver Prediction まとめ - copypasteの日記 |

| mercariコンペ | kaggle: Mercari Price Suggestion Challenge まとめ - copypasteの日記 |

コンペ概要

Avito(ロシアの大手広告サイト)が主催する商品の購入予測コンペです。データは数値データ + カテゴリデータ + 文章データ + 画像データでNLPとCVの知識が求められます。

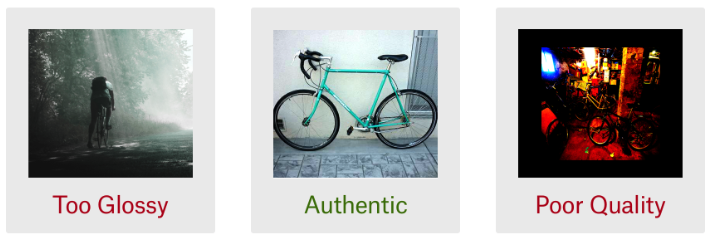

avitoはネットで簡単に個人間取引ができるサイト(メルカリのようなものを想像すればよいが、不動産や自動車、仕事なども売買できるらしい)です。出品時には商品説明や商品画像、価格などの情報を添えるのですが、それらの組合せによって商品の需要は大きく変化します。例えば以下の3つの画像を見てください。

全て自転車の写真ですが、左はかっこつけすぎですし、右はパット見だと何の写真かわかりません。自転車を買いたいユーザにとっては中央の写真が良さそうですね。(個人差はあるでしょうが)

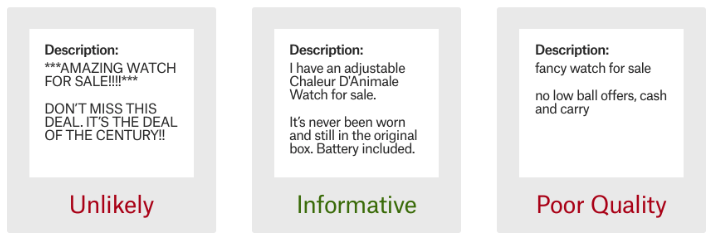

商品説明文も非常に重要で、以下の例を見ると中央の説明文が良さそうです。

広告リスティングや顧客満足度の観点から、出品時に商品需要を予測できれば非常に有益です。Avitoコンペではタイトル、説明文、画像、価格などの情報から商品需要を予測することを目的とします。 賞金・期間・参加者数などは以下の通りで、多様なデータを扱う難易度を考えると1873チームの参加は比較的多い印象です。

| 賞金 | 期間 | 参加チーム数 | 参加者数 |

|---|---|---|---|

| $12,000 | 2018/04/25 ~ 2018/06/25 | 1,873 | 2,363 |

データの種類とタスク

数値データ・カテゴリデータ・文章データ・画像データを用いた回帰問題です。通常のテーブルデータのように数値データやカテゴリデータがあるのは勿論、商品タイトルや商品説明文(文章データで)や商品画像データも与えられるため、データハンドリングの難易度は比較的高いと思います。

ファイルの種類とサイズは以下のとおりです。テーブルデータのサイズは小さいですが、画像データはそれなりに大きいです。ストレス無く実験するにはハイスペックPCかクラウド環境が必須になりそうです。主に使用するのはtrain.csv, test.csv, train_jpg.zip, test_jpg.zipの4つで、その他は追加データで必ずしも使用する必要はありません。(上位チームは追加データも上手く使用していた印象です)少し詳しく説明すると今回のtrain.csv, test.csvは広告の掲載期間で時系列分割されており、train_active.csv, periods_train.csv, test_active.csv, periods_test.csvの4ファイルは、train.csv, test.csvに含まれていないが同じ期間に掲載された商品のデータです。これらのデータは deal_probability(目的変数), image, image_top_1のデータが無いことを除いてtrain.csv, test.csvのデータを情報量と同じです。

| ファイル名 | データサイズ | レコード数 | カラム数 | 画像枚数 |

|---|---|---|---|---|

| train.csv | 909M | 1,503,424 | 18 | |

| test.csv | 316M | 508,438 | 17 | |

| train_jpg.zip | 49.4G | 1,390,837 | ||

| test_jpg.zip | 18.7G | 465,830 | ||

| periods_train.csv | 732M | 16,687,412 | 4 | |

| periods_test.csv | 602M | 13,724,922 | 4 | |

| train_active.csv | 8.6G | 14,129,821 | 15 | |

| test_active.csv | 7.9G | 12,824,068 | 15 |

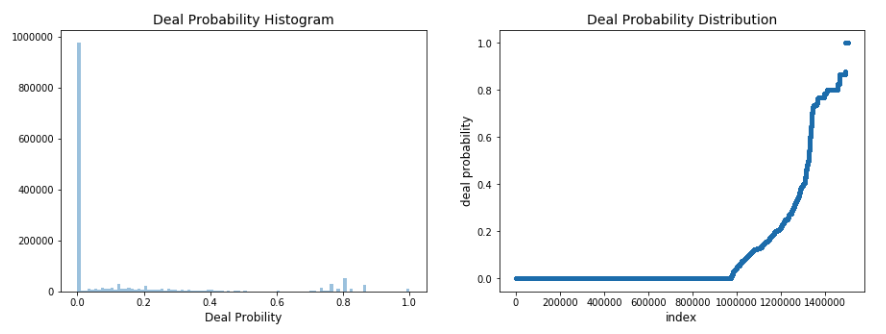

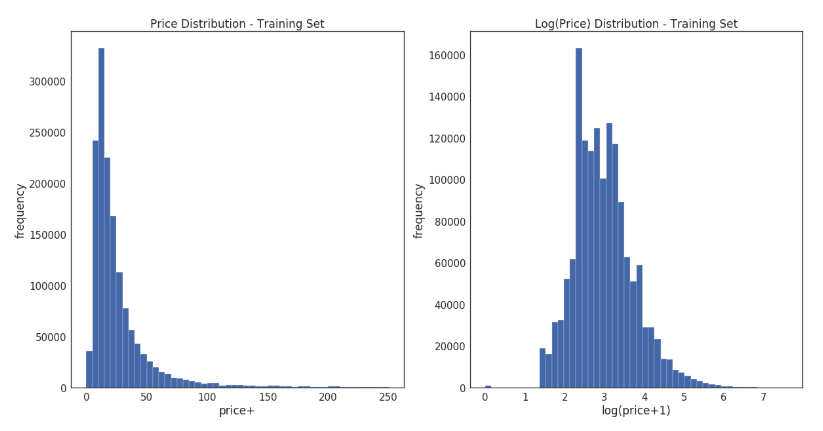

目的変数の分布は下図のとおりです。目的変数の値域は0~1の範囲で、64.8%は0です。画像は後ほど紹介しますがこのkernelを参考に微修正しました。

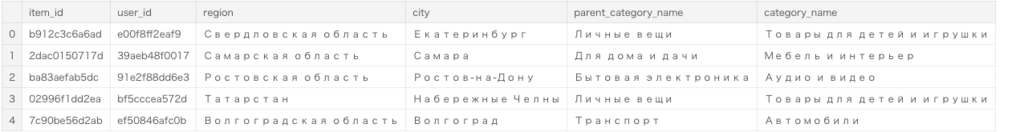

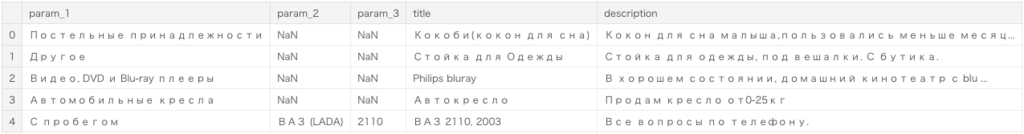

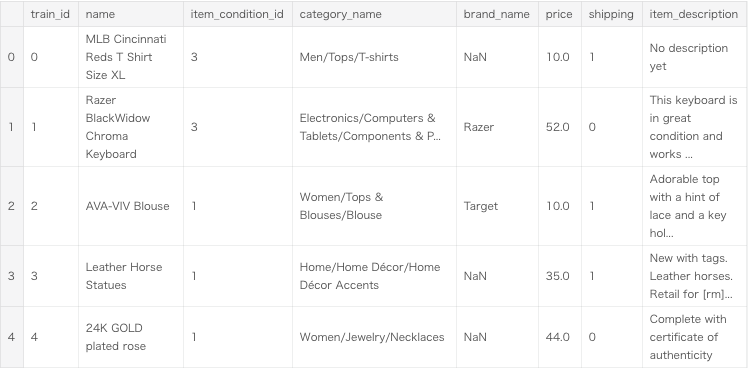

ちなみにtrain.csvのheadはこんな感じです。(カラム数の都合で画像を3枚に分けました)

各カラムの意味はデータ説明ページを見ていただきたいですが、商品ごとにカテゴリ、タイトル、説明文、価格などのデータがあることがわかります。また文章データはロシア語なので、データの理解は大変そうです。

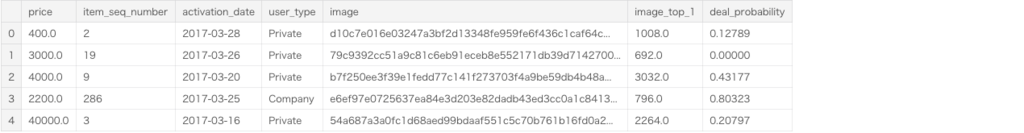

train_jpg.zipに含まれる画像はこんな感じです。画像サイズや商品のとり方はバラバラであることがわかります。また、必ずしも全ての商品に商品画像があるわけではないことに注意が必要です。

評価方法

評価指標はRMSEです。

提出方法

提出のフォーマットは以下のとおりです。商品ごとに取引確率を出力します。

| item_id | deal_probability |

|---|---|

| 2 | 0.1 |

| 5 | 0.25 |

| 6 | 1.0 |

勉強になる Kernel と Discussion

上位解法ほどのスコアは出せませんが、kernelとdiscussionは良いアイディアと実装で溢れています。どのアプローチも勉強になったので簡単にまとめておきます。

[Avito EDA, FE, Time Series, DT Visualization ✓✓ | Kaggle

EDA kernelです。データの確認、基礎集計・可視化、特徴量抽出、Treeモデルの変数重要度・木構造の確認までが簡単にまとめられています。以降の解法を読むにあたって簡単にデータを確認しておきたい方には見ておくことをおすすめします。ただし画像データに関しては触れられていないため別kernelを参照する必要があります。

Ideas for Image Features and Image Quality | Kaggle

画像データの基本特徴量抽出をまとめているkernelです。暗さ、明るさ、均一具合、代表色、画像サイズ、ぼやけ具合などの特徴量を算出しています。画像と特徴量の値が合わせて表示されているので各特徴量を直感的に理解できます。個人的にはぼやけ具合(Blurry)の特徴量が参考になりました。kernelにも参考リンクがありますが、ぼやけ具合特徴量はOpenCVのドキュメントが参考になります。

High Correlation Feature Image Classification Conf | Kaggle

学習済み画像識別モデルが確信度高く分類していれば、それは良質な画像であろうという仮説を検証するkerelです。 前提として、画像の質は需要に大きく影響するため、画像の質を表現できる特徴量は有効だろうと考えています。その上で、「画像識別モデルの確信度が高い」ことは「人間が画像内の商品を認識しやすい(画像の質が高い)」という仮説を立てています。画像識別モデルにはImageNetで学習済みのResNet50, InceptionV3, Xceptionを使用し、確信度(image confidence)には出力値(1000クラスの所属確率) の最大値を採用しています。 kernelの最後では、image confidenceはタイトルや文章の長さよりも目的変数との相関が高いことを確認しています。 仮説と実現方法のアイディアが面白いと感じたkernelです。

About image features & Image_top_1 features | Kaggle

Noohさんのコメントで、注目点(keypoint)の特徴量が紹介されています。実装にはcv2.FastFeatureDetector_createが使われており、注目点の説明はOpenCVのドキュメントが参考になります。イメージ図だけ載せておきます。

Aggregated features & LightGBM | Kaggle

複数テーブルの関係に関する基礎集計、基本特徴量抽出、LightGBMのモデリングまでがまとめられています。やっていること自体は単純ですが、確認すべきことをきちんと事前に確認しておく丁寧さが参考になりました。基本特徴量抽出では、出品期間・回数の特徴量、タイトル ・説明文の単語数由来の特徴量、CountVectorizer・TfidfVectorizerによる特徴量などが共有されています。

Simple CatBoost | Kaggle

基本特徴量を作成した上でcatboostでモデリングしています。特徴量は日付由来特徴量、カテゴリ変数をlabel encodingするといったシンプルなものですがcatboostを試してみたい方には参考になるかと思います。

Fasttext starter (description only) | Kaggle

特徴量に商品説明カラムのみ使用して fastText + RNN モデリングしているRNNのチュートリアルです。特別な工夫等は見られませんが、モデリングする上で必要最小限のコードが共有されているため初学者におすすめです。

text2image_top_1 | Kaggle

目的変数との相関が最も高い変数(image_top_1)の欠損をRNNの予測値で補完するkernelです。欠損値の補完はpd.DataFrame.fillnaで済ませることも多いですが、重要とわかっている変数に関してはモデリングして丁寧に補完する価値があるようで非常に参考になりました。

RNNの構造は embedding -> Bi-GRU -> concate[GlobalAveragePooling, GlobalMaxPooling] -> BN -> Denseと基本的なものなので、RNNのモデリングに興味ある方におすすめです。

load data (reduce memory usage) | Kaggle

Avitoコンペのkernelではありませんが、このAvitoのkernelが参考にしていたメモリ節約術に関するkernelです。pd.read_csvはデータの読み込み時に自動で型を認識するため便利ですが、メモリ使用効率はあまり良くありません。このkernelで共有されているreduce_mem_usage関数は使い勝手がいいので、別のテーブルデータに対してもpd.DataFrameのメモリを節約したいときにおすすめです。

Region and City Details with Lat, Lon and Clusters | Kaggle

region, cityの文字列とGoogle Maps APIから緯度・経度情報を情報を取得し、クラスタリングしています。クラスタリングにはHDBSCAN(Hierarchical Density-Based Spatial Clustering)を使用しています。(K-meansはクラスタサイズが均一となり不適切と判断したらしい)他のkernelがregion, cityを単にカテゴリで扱っているのに対して、region, cityの類似性に注目している点が面白いと思いました。HDBSCANと他のクラスタリングの違いについてはこのページが参考になります。

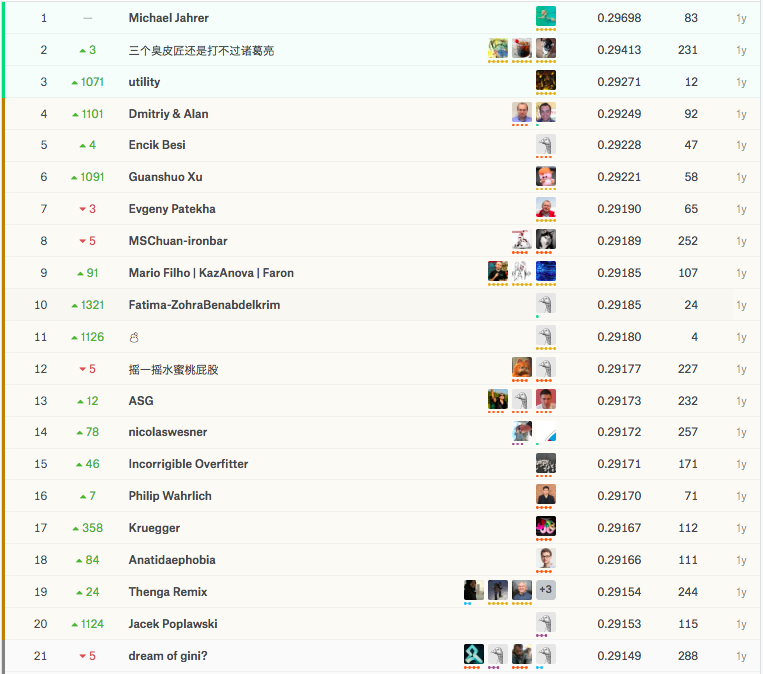

上位解法概要

上位解法はLightGBMとNNのアンサンブル解法が目立ちます。テーブルコンペの定石であるLightGBMに加えて、画像特徴とテキスト特徴を活かしたNNモデルを用意することが重要だったようです。マルチモーダルデータで上位を狙うにはGBDTとNNのアンサンブルは必須になりそうです。(Petコンペも然り)今回も1st ~ 3rdまでの解法をまとめたいと思います。

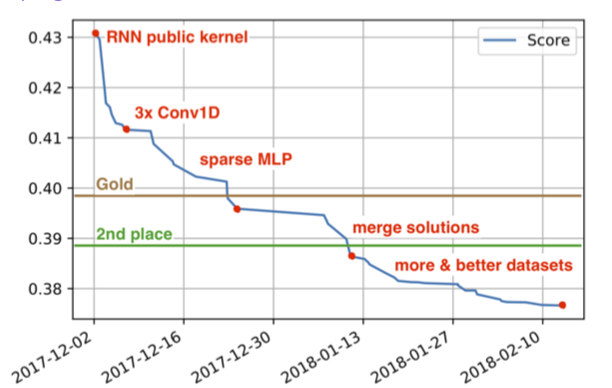

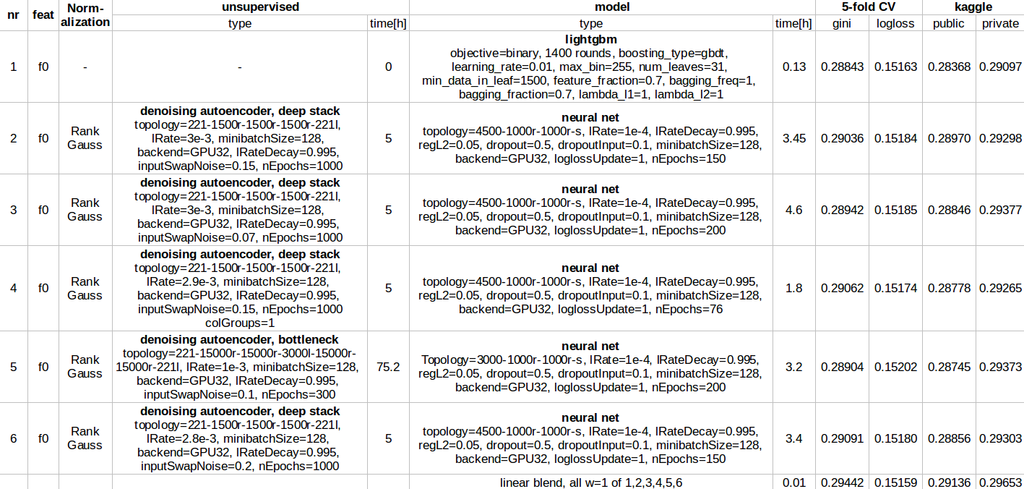

1st place solution: "Dance with Ensemble" Sharing Thread | Kaggle

grandmaster×3, master×1で構成されたdream teamです。最終的なモデルは3層のstackingで1層目(some lgb, some nn, some xgb)、2層目( some lgb, some xgb, one NN)、3層目(one nn)で構成されています。詳細なモデル数と役割分担はわかりませんが、各メンバーがそれぞれ強力なモデルを作成しています。 4人の解法が別々に公開されていましたが、個人的に勉強になった2人の解法をまとめます。

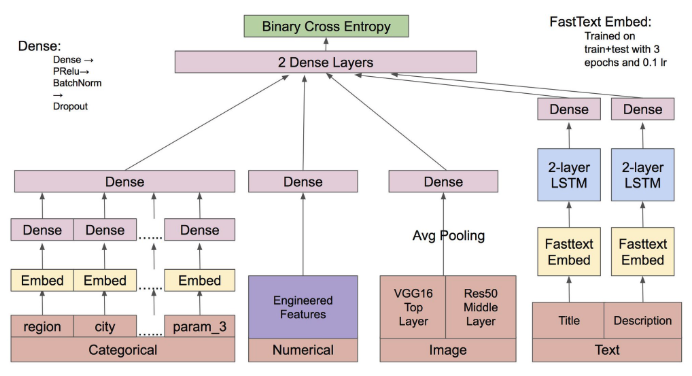

Little Boat さんの解法

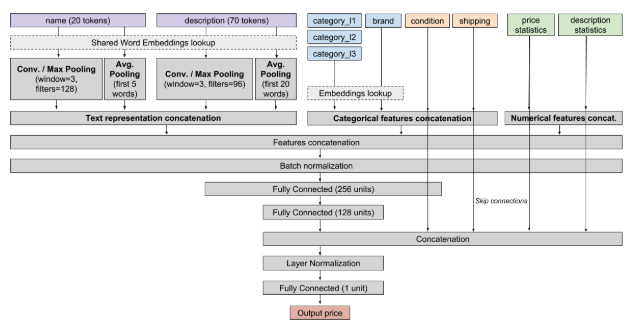

NNのモデリングに集中したようで、最終的にシングルモデルでtop10に入るスコアを記録しています。最終モデルは下図のとおりで、モデルの構造は勿論、それに至るまでのプロセスがとても参考になります。

以下に実験プロセスをまとめておきます。ミニマムなモデルからはじめて、成功/失敗要因を切り分けながら改良を加え続けたようです。

- 数値データ、カテゴリデータのembedding (0.227X)

- title, descriptionの学習済みfastText + 2×RNNを追加 (0.221X)

- train + testを使ってfastTextを一から学習(train_active, test_activeの使用も試したが失敗)(0.220X)

- VGG16 + average poolingを追加(0.219)

- fastText + 2×RNN を fastText + 2×LSTMに変更(CNNやAttensionも試したが失敗)(0.0003改善)

- ResNet50を追加(他のCNN、fine tuningに失敗)(0.218X)

- 直感を頼りにチューニング(spatial dropoutの追加など)(0.2165 - 0.217)

- チームメイトが作成した特徴量を追加(0.215X)

- ここまでの実験過程で保存したモデル群の最後にDenseを加えて学習(0.008改善: top10)

Arsenal さんの解法

Tree系モデルを担当したそうです。public LBでシングルモデルtop5を記録する強力なモデルを作成しています。 作成したモデルはstackingの1層目用に lgb×13, xgb×6、2層目用にlgb×12, xgb×7の計38です。特徴量について項目別にまとめます。

text features

- title, description, title+description, title+description+param_1などの組合せから作成したTFIDF特徴

- TFIDF特徴をSVDで次元削減したもの

- TFIDF特徴量で学習させたRedge回帰の予測値

- title, descriptionから作成した単語数/文字数/ユニーク単語数などの集計値

image features

- このkernelで紹介されている統計量

- 学習済みResNet50, InceptionV3, Xceptionの予測値(予測確率は連続値、予測カテゴリはカテゴリ変数として追加)

- このdiscussionのコメントで紹介されている注目点特徴量

categorical features

- カウント/ユニークカウント特徴量をデータセット・groupkey・ 集計対象を変えながら作成(組合せの例は以下の通り)

- データセットはtrain+test, train+test+train_active+test_active

- groupkeyはparent_category_name, category_name, param_1, region, cityなど

- 集計対象はitem_id, user_idsなど

- target encoding(組合せは様々)

predicted independent variables features

- 重要変数(price, image_top_1, item_seq_number, daydiff(date_to - date_from))をxgb, lgb, rnnで予測し予測値を特徴量に追加

- 様々なカテゴリでgroupbyした後、上記の予測値の平均値を特徴量として追加

- 予測値も使用して差分特徴量を作成((price - xgb_price)/price, log(image_top_1) - log(lgb_image_top_1)など)

user_id features

user_id由来の特徴量は過学習するため、stacking2層目でのみ使用したとのこと

- train+test, train+test+train_active+test_activeをuser_id, item_seq_number, activation_dateでソートし、user_idを含むカテゴリ(user_id+parent_category_name)でgroupbyした後、昇順/降順にインデックスを付与(user_idごとに0~1で正規化したインデックスも付与)

- user_idをカテゴリ変数として追加

- user_idと他のカテゴリ変数をgroupbyのkeyとして、unique item_seq_number, log1p(max(price)) - log1p(min(price))などの特徴量を作成

- periods_train+periods_testから以下の手順で特徴量を作成

- 行ごとにactivationtime(=date_from - activation_date), activationlen(date_to - date_from)などの差分特徴量を算出

- item_id毎にlagactivation(=activationdate - lag(activationdate), toactdiff(=activationdate - lag(date_to))などのlag特徴量を算出

- item_id毎に上記特徴量のmin, max, mean, std, countを算出

- user_id毎に更に上記特徴量のmin, max, mean, stdを算出

thousandvoice さん、Geogiy Danshchinさんの解法

2人の解法はLittle Boatさん、Arsenalさん、既に紹介したkernelとの共通部分も多いのでリンクだけまとめておきます。

2nd place solution: second place solution | Kaggle

NN, LightGBM, FM_FTRL, Ridge, CatBoostで6層のstackingをしたそうです。特徴量について簡単にまとめます。

- VGG16, ResNet50, MobileNetの予測値

- fastTextによるベクトル表現(データには title, description, title+city, title+categoryなど)

- 様々なカテゴリの組合せからprice, date_to - date_from などの基本統計量

- autoencoderによるカテゴリ変数のベクトル表現

- TFIDF, TFIDF+SVD

- target encoding

6層もstackingすることがあるとは驚きでした。初学者が真似をしても過学習して終わりそうです。

3nd place solution: 3 place solution | Kaggle

最終モデルは2つのensembleモデルをensembleしたもので、 2つのモデルはvalidation setの作り方を変えて作成したそうです。(1つは通常の5-fold、もう一方が時系列分割)

LightGBM features

- title, description から word, char それぞれでTFIDF特徴量を作成

- Word2vec, fastTextによる単語のベクトル表現(Word2vecのほうがfastTextよりよかったとのこと)

- 画像から算出した統計量

- ResNet, Inception, Xception の予測値

- 量的変数(priceなど)をbinに区切って離散化

- user_idごとの単語数、掲載日などの基本統計量

- 文章から算出した統計量

- 緯度/経度などの位置情報

NN

- best NN

- fasttext, word3vecをconcatしてbidirectional GRUs

- lgbで使用した特徴量

- カテゴリ変数をemmbeding layerで100次元に圧縮

- lossはbinary cross-entropy

- textデータはnltkでstemming

- title, description, paramsは分割を表す記号を挟んで結合

best NN 以外にチャネルごと(画像、テキストなど)にNNを構築したそうです。各々のNNの精度が高くなくてもstackingで有効だったとのこと。

その他の上位解法

discussionは解法の宝庫ですね。余力がある方はこちらもぜひ。

日本語記事

Kaggle Avito Demand Prediction Challenge 9th Place Solution

第5回 kaggle meetup の発表スライドです。5th place solutionの取り組みが紹介されています。linear quiz blendingという手法でスコアを伸ばしたようです。

世界一のデータサイエンティストを目指して 〜Kaggle参加レポート4〜 - Kysmo’s Tech Blog

株式会社キスモの方がAvitoコンペの参加記録を書いています。7th place solutionのテキストデータに対する工夫がわかりやすく紹介されています。stacknetが有効だったそうです。

AMD製GPUでKaggleにチャレンジする - 実践編 - - Qiita

Avitoコンペを題材にデータのダウンロードからサブミットまでの手順がまとめられています。

おわりに

なぜか気乗りしなかったので記事執筆から公開まで半年かかりました。この記事を書いていた頃はPetFinderコンペ(Avitoコンペと同じマルチモーダルデータのコンペ)に参加していて、Avito解法が非常に参考になった記憶があります。過去コンペまとめ記事を書き始めた頃はメダル0個のNoviceでしたが、約半年ほど経過してなんとかExpertに昇進することができました。過去コンペの解法研究なくしてメダル獲得はなかったと思うので、参加コンペに類似する過去コンペは積極的に調査していきたいです。PetFinderコンペのまとめ記事もそのうち(類似コンペが開催された頃に)書きたいと思います。

GBDTの理解に役立つサイトまとめ

GBDTは分析コンペや業務で頻出しますが、アルゴリズムの詳細はパッケージごとに異なるため複雑です。できることなら公式ドキュメント・論文・実装を読み込みたいところですが、私の実力的にそれは厳しいので参考サイトをまとめておきます。ゆるふわ理解に留まっている自分用のメモです。

GBDT

Gradient Boosting Interactive Playground

トイデータを使ってGBDTの挙動を確認できる。しばらく遊べる。

YouTube

とてもわかりやすい解説動画。Part1~4を視聴すればアルゴリズムの基本が理解できる。

- Gradient Boost Part 1: Regression Main Ideas

- Gradient Boost Part 2: Regression Details

- Gradient Boost Part 3: Classification

- Gradient Boost Part 4: Classification Details

よく見る下図のようなアルゴリズムを見てもビビらなくなる。

(2-3でlinear searchしている点は動画と異なる)

Boosting algorithm: GBM - Towards Data Science

アルゴリズムの概要からsklearnのsource codeの説明までほどよくまとまっている。

復習時に参照することも多く、個人的に好きなサイト。

XGBoost

日本語の記事が充実している。日本語記事で概要を把握してから論文を読むのが良さそう。

日本語の記事

いずれの記事もわかりやすくまとまっている。(調べれば他にもわかりやすい記事が見つかる)

「目的関数に正則化項を加える」、「二次のテイラー展開で近似する」とか言われてもビビらなくなる。

Boosting algorithm: XGBoost - Towards Data Science

アルゴリズムの概要からGBDTとの違いまで簡潔にまとまっている。

Tree Boosting With XGBoost - Why Does XGBoost Win "Every" Machine Learning Competition?

GBDTとXGBoostのアルゴリズムを勉強したいときこれを読めば良さそう。

ただし100ページ程度あるので、ちょろっと復習したいときには不便かも。

Tree Boosting With XGBoost — Why Does XGBoost Win “Every” Machine Learning Competition?

上で紹介した100ページ程度ある内容の要点がまとまっている。

復習時に参照することも多く、個人的に好きなサイト。

Newton tree boostingとGradient tree boostingの違いなどが整理できる。

Introduction to Boosted Trees — xgboost 1.0.0-SNAPSHOT documentation

公式ドキュメント

[1603.02754] XGBoost: A Scalable Tree Boosting System

元論文

LightGBM

XGBoostに比べて解説記事が多くない。さっさと論文を読むのが理解の近道かも。

NIPS2017読み会 LightGBM: A Highly Efficient Gradient Boosting Decision T…

LightGBM = GBDT + GOSS + EFB だとわかる。 GOSS、EFBのわかりやすい解説もある。

LightGBM and XGBoost Explained | Machine Learning Explained

XGBoost, LightGBM 独自の工夫に関して簡単な説明がある。

下記の用語を聞いてもビビらなくなる。

Features — LightGBM 2.3.2 documentation

公式ドキュメント

カテゴリ変数の分割方法(エンコーディング方法)について説明がある。

The basic idea is to sort the categories according to the training objective at each split. More specifically, LightGBM sorts the histogram (for a categorical feature) according to its accumulated values (sum_gradient / sum_hessian) and then finds the best split on the sorted histogram.

LightGBM: A Highly Efficient Gradient Boosting Decision Tree

元論文

CatBoost

XGBoostに比べて解説記事が多くない。さっさと論文を読むのが理解の近道かも。

YouTube

入門者向けの解説動画。イメージが掴める。

What’s so special about CatBoost? - Hanish Sai Rohit Pallapothu - Medium

CatBoostの概要が説明されている。

Categorical Feature Combinationsの説明もある。(重要だけど論文内であまり目立たない)

『CatBoost: unbiased boosting with categorical features』at NeurIPS2018読み会 - Speaker Deck

以下の項目が説明されおり、CatBoostの特徴を把握できる。

- Target statistics (TS)

- Greedy TS

- Orderd TS

- Prediction shift

- Orderd boosting

なぜCatboostの推論は速いの? - 簡単なレポート

Symmetric treeと推論時間に関して説明がある。

このtweetが理解の助けになりました。

CatBoostのSymmetric Treeの図を見て一瞬何これと思ったけど、これは木というか全データに同じ条件式を適用する操作をn回やって、結果のn-bitをleaf indexにしてるだけなのか。なるほどそれは推論速いという感じ

— Nomi (@nyanp) 2019年7月10日

[1706.09516] CatBoost: unbiased boosting with categorical features

元論文

Parameter

公式ドキュメント

ドキュメントを読もう。(自戒)

- Parameters — LightGBM 2.3.2 documentation

- XGBoost Parameters — xgboost 1.0.0-SNAPSHOT documentation

- Python package training parameters - CatBoost. Documentation

勾配ブースティングで大事なパラメータの気持ち - nykergoto’s blog

大事なパラメータのお気持ちが紹介されている。

Laurae++: xgboost / LightGBM - Parameters

LightGBM, XGBoostのパラメメータの対応関係がまとめられている。

Implementation

Kaggle Days TokyoでのGBDT実装の話 - threecourse’s blog

threecourseさんのGBDT実装資料がまとめられている。

勾配ブースティングを実装してみた - nykergoto’s blog

nykergotoさんのGBDT実装が紹介されている。

xgboostのコードリーディング(その3) - threecourse’s blog

xgboostのコード解説がある。

Imputation Method

Imputation Strategy @ Kaggle Days Tokyo (Maxwell) - Speaker Deck

欠損の起こり方・欠損値補間手法・XGBoostにおける欠損処理・XGBoostによる検証実験が紹介されている。 検証実験は欠損値補完なし・欠損値補完あり(MICE)・欠損値補完あり(MICE)+欠損値フラグの3通り。

機械学習における欠損値補完について考える - rmizutaの日記

LightGBMで欠損補完なしと欠損補間手法を用いた場合の比較実験が紹介されている。

推論時の入力に未知の欠損値がある場合のlightgbmの挙動の確認 - rmizutaの日記

LightGBMで欠損のないデータで学習し欠損のあるデータで推論した場合の挙動が紹介されている。

lightgbm カテゴリカル変数と欠損値の扱いについて+α - てばさきさんの自由研究

カテゴリ変数と欠損値に関する検証実験が紹介されている。

- label encodingして入力するのと、カテゴリカル変数として入力する違い

- trainに存在しないが、testには存在するカテゴリの扱い

Categorical Encoding

How to encode categorical features for GBDT - Speaker Deck

エンコーディング手法の紹介と各種手法の比較実験が紹介されている。

Target Encoding はなぜ有効なのか - Speaker Deck

GBDT学習時におけるLabel EncodingとTarget Encodingの違いが紹介されている。

LightGBMを少し改造してみた ~カテゴリ変数の動的エンコード~

LightGBMのカテゴリエンコードを変更する方法が紹介されている。

Other

Santander Product RecommendationのアプローチとXGBoostの小ネタ - Speaker Deck

XGBoostの実践テクニックが紹介されている。

PLAsTiCC 3rd Place Solution - Speaker Deck

カテゴリ変数が少ない場合にCatBoostが効果的だった例が紹介されている。

Interpretable Machine Learning with XGBoost - Towards Data Science

SHAPの説明がある。詳しく知りたい場合は以下を参照。

LightGBMのcallbackを利用して学習履歴をロガー経由で出力する - 天色グラフィティ

LightGBMのcallbackでログ出力するスクリプトが紹介されている。

Python: LightGBM の学習率を動的に制御する - CUBE SUGAR CONTAINER

学習率を動的に変更させる方法と実験結果が紹介されている。

決定木は本当に変換に依存しないのか? - 天色グラフィティ

LightGBMは説明変数のスケーリングに対して本当に頑健なのかが検証されている。

Allstate Claims Severity | Kaggle

LossをMAEに設定したときの挙動について議論されている。

GBDTを使ったfeature transformationの適用例

GBDTを用いた特徴量抽出テクニックが紹介されている。

Metric Learning 入門

- はじめに

- metric learningとは

- マハラノビス距離学習

- deep metric learningとは

- siamese network

- triplet network

- L2 softmax network

- MNISTで実験

- 天気データで実験

- まとめ

- おわりに

- 参考

はじめに

metric learningについて学ぶ機会があったので忘れないうちに得た知識を書き留めておきます。学んだ期間は10日程度と短く、deep learningも含めて初心者ですので疑いながら読んでいただければと思います。間違いを見つけた方はご指摘ください。本記事ではmetric learningの概要から画像データ・テーブルデータへの適用結果まで簡単に紹介します。

metric learningとは

metric learningとは データ間の計量(距離や類似度など)を学習する手法 です。直感的には、意味の近いデータは近く、意味の遠いデータは遠くなるように計量を学習 します。以下の図は靴の画像データに対してmetric learningを適応したイメージ図です。(画像はこのページから拝借しました。)

スニーカー同士、ブーツ同士、ヒール同士が近くに配置されていることがわかります。また、ヒールが高いほど右方向に配置されていることもわかります。このように、metric learningを応用すれば、靴の形状を考慮した距離を学習することができます。

ちなみに「計量を学習する」を「特徴量(特徴量空間)を学習する」あるいは「特徴量生成用の関数を学習する」と考えてもよいです。この考え方ついてはマハラノビス距離学習の説明時に軽く触れます。

metric learningの利点は意味的な距離を考慮した特徴量を学習できることです。教師ラベルを上手く準備できれば、特徴量空間の作り方(考慮したいデータの意味)をある程度コントールできます。 応用範囲は多義に渡り、例えば以下のようなタスクがあります。

- 情報検索/ランキング

- 異常検知

- 可視化

- クラスタリング

- 分類

意味的な距離を考慮した特徴量空間を上手く学習できれば、未知クラスのデータに対してもある程度頑健に対応できる点も強力です。 先程の靴の例だと、学習データに含まれない高さのヒールも空間の右上にうまいこと配置されるイメージでしょうか。

マハラノビス距離学習

metric learningの古典的な手法にマハラノビス距離学習があります。アイディア自体はdeep learningを用いたmetric learningと似ています。

マハラノビス距離学習では以下の式の共分散行列\( M \)を学習します。

\( M \)が決まれば距離が定まるので距離を学習していることになります。

ところで、\( M \)が半正定値行列であればマハラノビス距離は以下のように変形できます。

つまりデータ間のユークリッド距離が適切になるような変換\( L \)(あるいは特徴量\(L \boldsymbol{x}, L \boldsymbol{y} \))を学習する手法 とも考えられます。 このように、「計量を学習する」を「特徴量(特徴量空間)を学習する」あるいは「特徴量生成用の関数を学習する」と考えることができます。

次に\( M \) (= \( L \) )の決め方ですが、マハラノビス距離学習では以下の最適化問題を解けば良いです。\( S \)(類似データの組)と\( D \)(非類似データの組)は事前に用意しておく必要があります。よくある準備方法として、同じクラスのデータなら似ている、異なるクラスのデータなら似ていないとする方法があります。

このように似ているデータは近く、似ていないデータは遠くなるように学習させるのがmetric learningの特徴です。

deep metric learningとは

最近はdeep learningを用いたmetric learning(deep metric learning??)が注目されています。deep metric learningではマハラノビス距離学習で言うところの\( L \) ( = \( M \) )をdeep learningで学習します。これによって非線形変換が可能になります。

今回は以下の手法を順に紹介します。

- siamese network

- 2サンプルを一組で入力するやつ(contrastive lossと一緒に紹介)

- triplet network

- 3サンプルを一組で入力するやつ(triplet lossと一緒に紹介)

- L2 softmax lossを使ったnetwork(本記事ではL2 softmax networkと呼ぶことにします)

- metric learningっぽいくないけどそれなりに強いやつ

siamese network

siamese networkはずいぶん前(少なくとも2006年)に提案された手法です。(論文はこちら)特徴は2サンプルを一組で入力する点とサンプル間の距離をcontrastive lossで明示的に調節する点です。図の \( f \) をdeep learningに置き換えればdeep metric learningとなります。

マハラノビス距離学習と同様に、contrastive lossにも類似データは近く、非類似データは遠くするような工夫がされています。図にある通り、類似サンプルの組を入力した場合は \( d_i \) が小さくなるように、非類似サンプルを入力した場合は \( -d_i \) が小さくなるよう( \( d_i \) が大きくなるように)に学習させます。距離\( d \) は好きに選べば良いですが、元論文ではユークリッド距離が採用されていました。\( m \)(定数)を足してヒンジロスに通しているのは、\( -d_i \) を限りなく小さく( \( - \inf \) など)することでlossを下げる現象を防ぐためです。 metric learningで学習した特徴量を抽出する際は1サンプルずつ関数 \( f \) に通して、lossの手前の出力を使えば良いです。特徴量の抽出方法は他の手法も同様です。

triplet network

2014年に提案された手法です。今回はこの論文で紹介されているtriplet lossを紹介しますが、triplet network自体はこの論文で提案されています。最大の特徴は3サンプルを一組で入力する点です。

triplet networkもsiamese networkと同様に類似サンプル同士は近く、非類似サンプルが遠くなるようにlossを設計しますが、サンプルの準備方法が異なります。サンプルの組は以下の手順で作成します。

- 基準となるサンプル \( a_i \)(anchor)を選択する

- \( a_i \) と似ているサンプル \( p_i \) 、似ていないサンプル \( n_i \) を一つずつ選択する

サンプルの組を作った後は、各サンプルを同じ関数 \( f \) に通してlossを計算すれば良いです。また、contrastive lossと同様に距離 \( d \)は好きに設定できます

サンプルの選び方と直感的理解

siamese networkと同様にtriplet lossもサンプルの組の選び方が重要です。

サンプル選択の理解を深めるためにもう少し式を眺めてみます。

lossは低い程良いので青枠部分がゼロ以下になるのが理想です。ただし、この関係を満たすサンプルの組は学習に役立たない(既にlossがゼロ)ので、学習時には青枠部分がゼロより大きくなるサンプルの組(学習が難しい組)を選択した方が良いそうです。

ちなみに理想的な関係式を移行して図にすると以下のように描けます。

図のオレンジの線(非類似サンプルまでの距離)が青線(類似サンプルまでの距離)+緑線(マージン)より長くなるように学習させているわけです。

L2 softmax network

2017年に提案された手法です。(論文はこちら)contrastive lossやtriplet lossのように明示的に距離を操作することはしません。softmax関数の手前で2つの処理をするのが特徴です。(どうやら暗黙的にコサイン類似度で調節しているという話も聞きましたが知識不足でよくわかりません)

処理の内容は簡単で、softmax関数に通す前にL2ノルムで割って定数倍するだけです。L2ノルムで割る(=単位ベクトル化する)ことで、softmax関数で予測容易なサンプルの予測値を限りなく1に近づける現象を抑えているそうです。また、表現力を調整する定数 \( \alpha \) はハイパーパラメータで事前に決める必要があります。(正直あまり知りません)

MNISTで実験

MNISTデータを使って3つの実験をしてみました。基本的に同じ数字は似ている、違う数字は似ていない組としてmetric learningを行います。(実験1-3だけは別ですが)

実験条件

実験条件は以下のとおりです。

- CNNの構造

- Convolution(kernel_size=3)+ReLuを4つ重ねた後、全結合層256次元

- Convolutionのチャネル数は 16 -> 32 -> 64 -> 128

- 最適化手法

- Adam

- 特徴量抽出のタイミング

- lossの手前

- L2 softmaxの場合は単位ベクトル化する前

- データ

- train: 60,000枚

- test: 10,000枚

- チューニング

- ほぼしていません。

実験1-1: 表現力の確認

まずはmetric learningがそれっぽく動作してくれるのか確認しました。実験手順は以下のとおりです。

- 10クラスで学習し、可視化

- metric learningで得た特徴量を用いて分類モデルを学習し、精度評価

まずは10クラスで学習した後、試験データの1000サンプルをtSNEで可視化しました。

no metric learning(metric learning未使用)はデータが混ざり合っており、metric learningを使った場合は上手く分かれているように見えます。また、contrastive lossとtriplet lossはデータ間の距離を考慮しているようにも見えますが、L2 softmaxは全体的にきっちりわける傾向が強いように見えます。(曖昧な表現をしているのはtSNEも多様体学習しており、2次元プロットの距離が高次元空間の距離を反映しているとは限らないためです)

次にクラスごとに特徴量ベクトルのセントロイドを算出して、セントロイド間の距離をヒートマップで可視化してみました。

距離は0~1にスケールしてあります。

文字が小さくて恐縮ですが、no metric learning, triplet loss, contrastive lossに関してはtSNEの可視化と同様の傾向が見て取れます。一方でL2 softmaxに関しては、tSNEの可視化では近く見えた3と5も実は遠い距離にあることがわかります。 (L2 softmaxを使用した場合にはコサイン類似度を使用したほうが良さそうですが、今回は比較のためにユークリッド距離を使用しています。そもそも直接比較はできない数値なのであくまで参考程度に)

次にmetric learningで得た特徴量を用いて分類モデルを学習させました。評価指標はaccuracyです。

no ML(metric learning未使用)よりもmetric learningのほうが高いaccuracyを示しています。中でもL2 softmax lossが特に優れています。これはL2 softmax networkが分類モデルを学習させている(最終的にsoftmaxでlossを計算している)ため、分類モデルにとって都合の良い特徴量を作成しているのだと思います。後段で分類モデルを使いたいならL2 softmaxが良さそうです。

実験1-2: 未知クラスの表現力を確認

次に未知クラスの特徴量をそれっぽく再現できるか実験してみました。実験手順は以下の通りです。

- 3, 4を除いた8クラスで学習し、可視化

- metric learningで得た特徴量を用いて分類モデルを学習し、精度評価

まずは8クラス(数字の3, 4以外)で学習した後、3, 4も合わせてtSNEで可視化しました。 実装はtriplet lossとl2 softmax lossで行いました。 3, 4以外は比較的分かれており、4は9の近く、3は丸みを帯びた文字の近くに位置していそうです。

生成した特徴量を用いてKNNを学習させました。KNNには3, 4も訓練データとして与えています。正規化済みの混同行列は以下のようになりました

metric learningモデルにとっての未知クラスの分類精度(オレンジ部分)はtriplet lossのほうが良いことがわかります。未知クラスを扱うときはtriplet lossが有効ということでしょうか。既知クラスの精度でL2 softmax lossが強いことは実験1-1の結果と一致します。triplet lossの精度を見るとクラス3が0.93、クラス4が0.85とそこそこ高いので未知クラスでもそれっぽい特徴量を作成できたことがわかります。

実験1-3: 奇数/偶数を学習

最後に奇数(1, 5, 7, 9)と偶数(0, 2, 6, 8)の2クラスで類似/非類似の組を作って実験してみました。 奇数/偶数で数字の形は必ずしも似ていないので少し無茶ぶりをしたつもりです。実験手順は以下の通りです。 実装にはtriplet lossを使用しました。

- 3, 4を除いた上で奇数/偶数の特徴量を学習し、可視化

- 3, 4も合わせて可視化し、位置を確認

まずは3, 4を抜いて学習させて可視化してみました。 左図はtSNEの可視化、右図が各クラスのセントロイド間のユークリッド距離を0~1に正規化したものです。

tSNEの可視化結果を見ると奇数/偶数で分離できそうに見えます。

右図の距離行列を見ても、奇数は奇数同士近く、偶数は偶数同士近く、奇数と偶数は遠く配置されていることがわかります。

無茶ぶりのつもりでしたがdeep learningにとっては簡単なタスクだったのでしょうか。

次に未知クラス(3と4)も合わせて可視化してみました。

4と9、 3と5が混ざり合っているように見えます。 今回の学習方法だとdeep learningは偶数/奇数の概念までは学習できないので4は奇数側(9の近く)に寄ってしまいました。 未知クラスも視野に入れるなら、metric learningで考慮したい意味(距離)は慎重に考える必要がありそうです。

天気データで実験

日本の天気データを使ってMNISTと似たような実験をしてみました。テーブルデータでもそれっぽく学習できるのか確かめることが目的です。

データの準備

気象庁のページから過去11年分の12都道府県の天気データをダウンロードしました。データは1時間おきの計測データで、クローリング失敗やそもそもの欠損などはpandasのdropnaで雑に処理をしました。必要なカラムだけ抽出して整形したデータは以下の通りです。今回は同じ都道府県ならば似ている、異なる都道府県なら似ていないとしてmetric learningしてみます。

入力データの次元があまりに少ないと面白くないので、1日1サンプルとして最大で12都道府県×11年×365日分のサンプルを用意しました。(実際には1/3程度が欠損で消えましたが...)都道府県ごとのサンプル数は沖縄が最大で3682サンプル、神奈川が最小で1425サンプルで若干隔たりがあります。

特徴量としては月(ダミー変数)と以下の項目を用意しました。ダミー変数を含めると52次元のデータとなります。画像データと比べると次元はかなり少ない印象です。

データの準備はとても雑ですが、ひとまずこれで準備完了です。

実験条件

実験条件は以下のとおりです。

- MLPの構造

- 全結合層(256次元)+ReLUを3つ

- 最適化手法

- Adam

- 特徴量抽出のタイミング

- Lossの手前

- L2 softmaxの場合は単位ベクトル化する前

- データセット

- train: 9年分(2008年 ~ 2017年)

- test: 2年分(2017年 ~ 2019年)

- チューニング

- ほぼできていません

実験2-1: 表現力の確認(その1)

まずは簡単そうな問題設定で動作確認をしてみました。実験手順は以下のとおりです。

- 4クラス(札幌、東京、大阪、沖縄)で学習し、可視化

- metric learningで得た特徴量を用いて分類モデルを学習し、精度評価

下図がtSNEの可視化結果です。metric learning未使用の場合は季節や月でクラスタができているように見えます。

札幌と沖縄の特徴量表現は比較的簡単ですが、東京と大阪の違いを学習させることは少し難しいようです。 triplet loss, L2 softmax lossは東京と大阪もある程度分離できていますが、contrastive lossは混ざり合っているように見えます。 ひとまずテーブルデータでもそれっぽく動作することが確認できました。

次にmetric learningで得た特徴量を用いて分類モデルを学習させました。評価指標はaccuracyです。

MNISTのときと同様に、metric learningを使ったほうが精度が高い結果となりました。 今回もL2 softmaxが最良の結果を示しています。

実験2-2: 表現力の確認(その2)

クラス数を増やして実験2-1と同様の実験をしてみました。クラス数が増えるので難易度も上がります。実験手順は以下のとおりです。

- 9クラス(札幌、青森、山形、東京、富山、奈良、山口、福岡、沖縄)で学習し、可視化

metric learning未使用の場合は実験2-1と同様に季節でクラスタが分かれているように見えます。 metric learningを使うことでクラスタが一つになるようですが、タスクが難しくなったせいか全体的にやや混ざり合っているように見えます。また、contrastive lossはミミズ型になりやすく少しチューニングに手間がかかりました。

下図は各クラスのセントロイド間のユークリッド距離を0~1に正規化したものです。 地理的な関係が反映されているかどうかはさておき、contrasitve lossとtriplet lossは距離を学習している気配があります。L2 softmaxは相変わらずはっきりと分ける傾向にあり、沖縄を除くとどの都道府県も似たような距離関係にあります。

実験2-3: 未知クラスの表現力を確認

最後に未知クラスの特徴量をそれっぽく再現できるか確認してみました。triplet lossとL2 softmax lossで実装しています。実験手順は以下の通りです。

- 9クラス(札幌、青森、山形、東京、富山、奈良、山口、福岡、沖縄)で学習し、未知クラス(秋田、神奈川、大分)も含めて可視化

- metric learningで得た特徴量を用いて分類モデルを学習し、精度評価

9クラスで再度学習させてtSNEで可視化してみました。左図は既知クラスのみ、右図は未知クラスも含めて可視化しています。 既知クラスのほうは辛うじてクラスごとのクラスタを確認できますが、未知クラスのほうは完全に混ざり合っているように見えます。 秋田は青森と、神奈川は東京と、大分は福岡と混ざり合ってしまったようです。チューニングすればある程度改善できると思いますが、タスクとして少し難しかったのかもしれません。

実験1-2と同様にmetric learningで学習した特徴量を用いて分類問題を解いてみました。正規化済みの混同行列は下図の通りです。

未知クラスの精度が著しく低いことがわかります。やはり既知クラスと混ざり合ってしまい上手く特徴量を表現できなかったようです。 一応2種類のlossを比較しておくと、未知クラスにはtriplet lossが強く、既知クラスにはL2 softmax loss が強いという実験1-2と同様の結果が得られました。

まとめ

- metric learningは計量を学習する手法

- 意味的な距離を考慮した特徴量を作成できる

- 画像だけでなくテーブルデータにもある程度機能する

- 実データで使えるかどうかはよくわかりません

- 意味的な距離を考慮したいならtriplet loss

- 未知クラスを主に扱うならtriplet loss

- 分類タスクの特徴量生成に使うならL2 softmax loss

- 素人のブログなのであまり信じすぎないでください

おわりに

metric learningの概要からToyデータによる実験結果まで簡単に紹介しました。冒頭でも述べた通り、私自身metric learningを学び始めて間もないですので、記事中に間違いがある可能性は非常に高いです。間違いを見つけた方はご指摘ただければと思います。感想としてはlossの設計で特徴量空間をある程度コントロールできるのは面白いと感じました。本記事で紹介していないlossやautoencoderとの組み合わせなど、データを変えながら遊んでみたいです。そういえばkaggleのタンパク質コンペ(?)の1st place solutionがmetric learningを使った解法だったそうです。今後はコンペでも積極的に使用されるかもしれませんね。

参考

[1] deep metric learningによるcross-domain画像検索 - ZOZO Technologies TECH BLOG

[2] Deep Metric Learning Using Triplet Networkの論文を流し読む – Urusu Lambda Web

[3] http://researchers.lille.inria.fr/abellet/talks/metric_learning_tutorial_CIL.pdf

kaggle: Mercari Price Suggestion Challenge まとめ

過去コンペまとめ記事の三作目です。タイトルにもあるように今回は2017年11月にkaggleで開催されたMercari Price Suggestion Challengeをまとめたいと思います。これまでにToxicコンペとPort Segroコンペのまとめ記事も書いてますのでよければそちらもご覧下さい。以下にリンクをまとめておきます。 メルカリコンペは株式会社メルカリが主催した、商品の販売価格予測コンペです。テーブルデータですが文章データも含まれているためNLPの知識が必要になります。 また、kernel only コンペなので実験環境と実行時間に制限があることも特徴です。 賞金・期間・参加者数は以下の通りで、 同じNLPコンペであるToxicコンペと比較すると参加者は少ない印象です。ルールが特殊(kernel only & 2stage制 )であることは理由の一つかもしれません。 メルカリコンペでは通常のコンペには無い2つの特別ルールが設けられていました。それぞれ kernel only, 2stage と呼ばれるものです。 kernel onlyコンペでは予測結果のファイルだけでなく、前処理〜モデリング〜ファイル出力までのスクリプトをkernelごと提出する必要があります。

kernelはマシンスペックや実行時間が決まっているため、通常コンペのように潤沢な計算資源と計算時間を活用することができません。当時のkernelの環境は 4cores / 16GB RAM / 1GB disk / GPUなし で計算時間を60分未満にする必要がありました。 2stageの特徴はprivate LB用の評価データが配布されないことです。通常は配布されたテストデータの一部をpublic LB用の評価データ、残りをprivate LB用の評価データとするのが基本です。一方の2stageコンペでは、配布されたテストデータの全量がpublic LB用の評価データ(stage 1)、競技者には非公開のテストデータがprivate LB用の評価データ(stage 2)となります。 kernel only × 2stage のコンペでは計算時間の観点で注意が必要です。それはprivate LB用の評価データでスコア計算をする際もkernelの時間制約を満たす必要があるためです。メルカリコンペでは private LB用の評価データサイズがpublic LB用の評価データサイズの約5倍と大きかったので、stage2で計算時間制約を守れず(あるいはメモリ制約を守れず)スコアがつかなかった競技者が続出しました。(769/2384チームがスコアなし)事前に対策をすれば防ぐことは可能ですが、private LB用の評価データは非公開(サイズのみ公開される)であるため計算時間の見積もりには注意が必要です。 テーブルデータ(数値データ+カテゴリデータ+文章データ)を用いた回帰問題です。商品ごとに販売価格を予測するモデルを構築します。テーブルデータですが文章データも含まれるためNLPの知識が必要になります。 データサイズは以下のとおりです。test_stg.tsv(コンペ開催中は非公開のstage2用の評価データ)のサイズがtest.tsvの約5倍であることに注意する必要があります。2stageコンペでは必ず確認しましょう。データサイズは比較的小さい印象です。 ちなみにtrain.tsvのheadはこんな感じです。商品ごとに商品名、ブランド名、価格などのデータが与えられています。

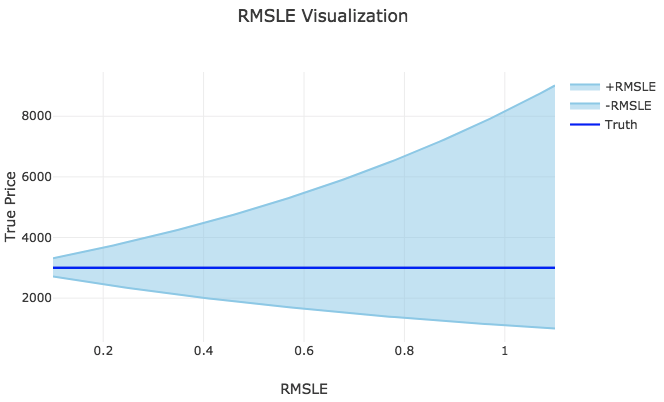

各カラムの意味は以下のとおりです。正確な説明はデータ説明ページを御覧ください。 評価方法はRMSLE (Root Mean Squared Logarithmic Error)です。つまりlog1pをとった上でRMSEで評価することになります。評価指標がRMSEなのでLightGBMやNNを使えば評価指標を直接最適化することができます。 仮にRMLSE=1.0の場合は推定値の誤差範囲は¥1,103 ~ ¥8,156となります。図から分かる通り、logをとるため誤差範囲の上振れ幅と下振れ幅は等しくなりません。

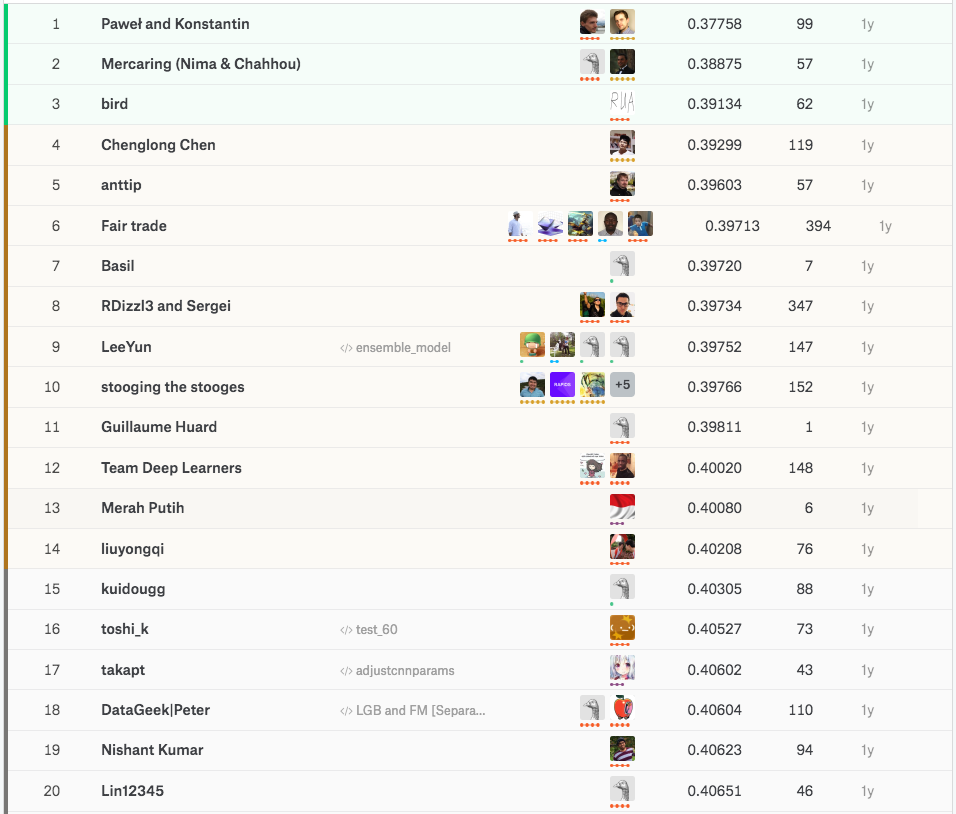

ちなみに一位のチームがコンペ終了後に公開したkernelはRMLSE=0.3875で、誤差範囲は¥2,051 ~ ¥4,387でした。これは実際のプロダクト上でも稼働可能なスコアだそうです。 提出のフォーマットは以下の通りで、IDごとに予測価格を出力します。 上位解法ほどのスコアは出せませんが、kernelとdiscussionは良いアイディアと実装で溢れています。どのアプローチも勉強になったので簡単にまとめておきます。 EDAとNLPチュートリアルがまとめられています。以降の解法を読む上で一度データを確認しておきたい方は、EDA部分だけでも見ておくことをおすすめします。 文章データの分析では「特徴量抽出 -> クラスタリング -> 次元圧縮 -> 可視化 -> 結果解釈 」の順に作業することはままあると思うので初学者におすすめです。 基本的な特徴量抽出をした上でRidge 回帰でモデリングしています。処理手順を箇条書きにすると以下のとおりです。 これらのアイディアは他のkernelでも頻出するので、理解を深めたい方は一度kernelをForkして手を動かしてみると良いかもしれません。 Ridge回帰モデルの変数重要度をELI5で可視化しています。下図を見ればわかるように単に回帰係数を眺めるよりも重要変数の把握が捗ります。

変数重要度の算出アルゴリズムとしてpermutation importance, LIME, SHAPなどが知られていますが、雰囲気だけでも知りたい方はkaggle learnのMachine Learning Explainabilityがおすすめです。 entity embeddingを応用したNNのベースラインモデルです。 各変数をembedding層でベクトル表現 -> 系列データにGRUを適用 -> 全変数をconcateしてDense + dropoutの構造でNNを構築しています。kerasを使ったtokenizeから学習までの必要最低限のコードなので初学者におすすめです。 FTRL, FM_FTRL, LightGBMのensembleをしています。FTRL, FM_FTRLの実装はToxicコンペでも登場したwordbatchライブラリを使用しています。予測時には加重平均をとっており、重みはFTRL : FTRL_FM : LightGBM = 0.18 : 0.55 : 0.27としています。重みの決め方についての言及はありませんが、FTRL_FM > LightGBMの関係をみるにFTRL_FMも強力な手法なのでしょうか。(知識不足でよくわかりません) kernelコンペの性質上シンプルな解法が多い中、比較的複雑なモデルがあったので紹介します。シングルモデルですがシルバーメダル相当の強力なNNモデルで、構造は以下の通りです。 正直なところNN初学者の私にはこの図以上のことは説明できません。図のprice statistics部分では category_name, brand_name, shippingをgroupbyのkeyとしてmedian, mean, stdの統計量を算出した後、それらを四則演算することで特徴量を作成しています。 本コンペの1位チームがコンペ終了後に公開したkernelです。1st place solutionの核となる部分だけまとめた解法で、解法自体はシンプルですが非常に強力なkernelです。後でも紹介しますがtkmさんの解説動画を見ると理解が捗ると思います。モデルは隠れ層が3層のMLPです。 上位解法はNN解法が目立ちます。LBを見ると1位のスコアが飛び抜けており、discussionを見る限り1位・2位の方が途中でチームマージしてトップを走り続けたようです。1位解法は非常にシンプルなNNで構成されており、多様性の出し方やモデリング方法など必見です。今回も1位〜3位解法をまとめます。

最終的な解法は12個のMLPのアンサンブルです。いろいろ試行錯誤した結果、複雑なモデルからシンプルなモデルに収束したようです。チームマージ前とチームマージ後の解法が共有されていたため順にまとめようと思います。(マージ後の最終モデルが見所です)ちなみにスコアの推移は以下の通りで、マージ直後のモデルでも1位相当のスコアを記録していることが分かります。

複雑なモデルを作成していたそうですが、詳細な説明がないため雰囲気しか分かりません。ポイントは以下の3つだそうです。 個人的に残差モデルを作ってboostingさせるアイディアは初見だったので勉強になりました。 モデルはMLPとCNNのアンサンブルです。こちらも詳細な説明がないため雰囲気だけまとめます。 kernel onlyの制約上、上記2つの解法を愚直にアンサンブルすることはできず、双方のアイディアを取り入れた一つのモデルを構築するのに苦戦したそうです。(ここで2週間ほど費やしたらしい) 結局、3種のデータセットと4つのモデルを使ったアンサンブルに落ち着いたとのこと。多様性を出すために以下の項目を組合せたようですが、どのように組合せたかはわかりません。 モデルは適切にチューニングされた12個のMLPアンサンブルです。実験を通じて同じデータで異なるモデルを学習させるよりも、異なるデータを同じモデルに学習させたほうが多様性を表現できることに気づき、モデルはMLP(MLPの構造は一種類ではない)と決めたそうです。 計算時間制約を考えてもMLPは都合が良かったとのこと。

解法のポイントを7つに分けてまとめます。(正直知らない工夫ばかりでテンション上がりました) 1位解法最大の特徴です。3種類のデータセットに対して4つずつMLPモデルを構築しています。各データセットでMLPの構造は基本的に同じですが、計算時間を考慮して入力層のユニット数は少し調節されていました。(192が2つと128がひとつ)

確かに全てMLPですが、データセットを変えたり、後で説明する2種類のMLPを用意したり、学習/ 推論の直前で特徴量を2値化したりと多様性を与える工夫がちりばめられています。 最終モデルのソースコードはgithubに共有されているので詳細を知りたい方はこちらをご覧ください。 構築したMLPは2種類に大別できます。一つは損失をHuber lossとした回帰モデルで、もう一つが分類モデルを経由した回帰モデルです。各データセットに対して2つずつ学習させていました。評価指標がRMSEであるにも関わらずHuber lossで最適化する点や、回帰問題をあえて分類モデルで解くあたりが独創的だと感じました。ちなみにHuber lossモデルは隠れ層が3つ、分類モデルは隠れ層が2つの構造です。分類モデルを経由した回帰モデル作成の手順を簡単にまとめておきます。 この分類モデルを経由した回帰モデルは、過学習することなく単体で良いスコアを記録したようです。それに加えてモデルの多様性の観点からもアンサンブルに貢献したそうです。 どのデータセットもCountVectorizerとTfidfVectorizerを用いたスパース特徴量が基本になります。使用カラム(name, item_description, category_name)、Cleaningの有無、ベクトル表現方法(CountVectorizer, TfidfVectorizer)、ngramの範囲、binary表現有無 などの組合せから、様々なスパース行列を作成し、データセットごとに使用するスパース行列の組合せを変えています。 学習/推論の直前で特徴量を全て2値化(非ゼロか否か)する処理を加えています。この処理をするモデルはデータセットごとに2つでHuber lossモデルと分類モデルの1つずつでした。2値化するための閾値はいくつか試したそうですが、それによるスコア改善は見られなかったようです。 学習速度のチューニングは非常に重要だったらしく、特にepochごとにbatch sizeを2倍にすることは学習を早めると同時にスコア向上につながったそうです。それに加えてepochごとに学習率を上げることで、徹底的に学習速度を速める工夫をしています。これらのパラメータは2epoch目で最良のvalid score、3epoch目で過学習するようにチューニングしたそうです。 1層目にL2正則化を加えることは効果的だったようです。またtensorflowモデル(あとで説明しますが2種のpackageでモデルを作っている)ではRELUよりもPRELUが効果的だったそうです。 最終的に選択した2つのsubmit(コンペ終了前に提出用のsubmitを2つ選択するルールがある)はtensorflowとMXNetそれぞれで実装したモデルにしたそうです。packageを複数使った理由は読み取れませんでしたが、tensorflowは各コアで別のモデルを学習でき、MXNetはスパースデータに対するCPUのMLP実装が効率的で実行時間が短かいなどの特徴があったのだとか。メモリ使用量やmultiprocessingに関しても説明されていますので興味のある方はdiscussionを読んでみてください。 4つのモデル(Redge×1, NN×3)を構築しています。その他にもLightGBMを学習させたようですが上手く機能しなかったそうです。同じデータで異なるモデルを学習させる方法はうまくいかなかったので、データを変えて異なるNNモデルを複数用意したとのこと。RidgeとNNについてそれぞれ簡単にまとめます。 特徴量は1-ngramとアレンジを加えたbigramsです。1-ngramsは商品名と商品説明に対してそれぞれ適用したそうです。アレンジを加えたbigramsの処理手順は以下のとおりです。 このようなbigramsのとり方は初見だったので参考になりました。 特徴量を変えたNNを3つ構築しています。特徴量のバリエーションは以下のとおりです。また、1位解法と同様に、epochごとにbatch sizeを2倍にして学習速度を速めたそうです。 2nd place solution kernelが公開されているのでモデルの詳細を知りたい方はこちらをご覧ください。NN構造は公開kernelと比較的似ているため省略します。 モデルはNNとFMのensembleです。最終出力は2モデルの加重平均(NN×0.6 + FM×0.4)としたそうです。各モデルで使用した特徴量とNNに関してはモデル構造を簡単にまとめます。NNの構造構築に特に注力したそうです。 使用した特徴量は以下のとおりです。 使用した特徴量は以下のとおりです。 NNは図のような構造をしています。(図は私が作成したので間違いがある可能性があります。input1~4の項目は自信が持てなかったので記入しませんでした。)モデルの詳細を知りたい方は 3rd place solution kernelをご覧ください。 またNNの学習パラメータは1epochずつ以下のように設定したようです。7epoch目でwomen, beautyカテゴリのデータに絞っているのは、データの大多数が女性向け商品であるため女性向け商品を重要視して学習させるためだそうです。 discussionは解法の宝庫ですね。余力がある方はこちらもぜひ。 メルカリコンペの閉会式に関するまとめ記事です。閉会式では上位入賞者の解法発表やパネルディスカッション形式のトークなどが企画されたようで、その時の動画が共有されています。パネルディスカッションは日本語動画ですので英語が苦手な方でも見ることができます。 メルカリコンペを題材にした機械学習初心者向けのkaggleチュートリアルです。コンペ概要説明〜データの確認〜前処理〜ランダムフォレストによるモデリング まで丁寧に説明されています。 tkmさんの優勝コード解説動画です。コードやモデルのどこがすごいのか丁寧に説明されているのでおすすめです。 St_Hakkyさんもメルカリコンペのまとめ記事を書いていました。twitterのつぶやきや企業がコンペに出す意味についてもまとめられています。 今回はメルカリコンペをまとめました。ベジネスでの活用シーンもイメージしやすく、馴染みのあるアプリが題材ということでいつも以上に楽しめた気がします。特に1st place solutionは衝撃的で、やや興奮状態でまとめ記事を書いた記憶があります。シンプルでありながら工夫が各所に散りばめられていて本当にかっこいいです。kaggleには他にもすごい解法や知見があると思うとわくわくしますね...!! 次回はAvitoかQuoraあたりをまとめるつもりですので良ければそちらも御覧ください。

はじめに

コンペ略称

リンク

Toxicコンペ

kaggle: Toxic Comment Classification Challenge まとめ - copypasteの日記

Porto Seguroコンペ

kaggle: Porto Seguro's Safe Driver Prediction まとめ - copypasteの日記

コンペ概要

メルカリは誰でも簡単に売買ができるフリマアプリで、出品時に売り手が商品の価格設定をする必要があります。その際、価格を相場以上にすると売れませんし、相場以下にすると損をしてしまいます。出品する前にきちんと相場を調べておけば解決できますが、手間がかかりますし、そもそも調べ方がわからない人も少なくありません。そのような背景から、出品時に適切な販売価格を提示してくれるシステムがあると便利そうです。そのようなシステム導入を視野に入れて、メルカリコンペでは出品時に商品の適切な販売価格を予測することを目的とします。

賞金

期間

参加チーム数

参加者数

$60,000

2017/11/22 ~ 2018/02/22

2,384

2,782

特別ルール

kernel only

2stage

特別ルールの影響

データの種類とタスク

目的変数の分布は下図(左)の通りで歪んだ分布となっています。下図(右)はlogをとった場合の分布ですが、①分布が正規分布に近づく②評価指標がlogをとった上でのRMSEである(後で説明します)ことからlogをとった上で予測することが定石だったようです。画像は後ほど紹介しますがこのEDA kernelから拝借しました。

ファイル名

データサイズ

レコード数

カラム数

train.tsv

322M

1,482,535

8

test.tsv

147M

693,359

7

test_stg2.tsv

737M

3,460,725

7

カラム

意味

train_id

商品ID

name

商品名

item_condition_id

商品の状態

category_name

3分類のカテゴリ

brand_name

ブランド名

price

価格(目的変数)

shipping

送料が売手負担か否か

item_description

商品説明

評価方法

RMSLEの直感的説明は後で紹介するこのページで紹介されています。以下の図は¥3,000の商品に対してRMSLEを変化させたときの推定値の誤差範囲を表しています。

提出方法

test_id

price

0

1.5

1

50

2

500

3

100

勉強になる Kernel と Discussion

Mercari Interactive EDA + Topic Modelling | Kaggle

NLPチュートリアルは本コンペの目的と直接の関係はありませんが、NLPで有名な手法(よく使われる手法??)が順に紹介されています。説明されている項目は以下のとおりです。

Ridge Script | Kaggle

ELI5 for Mercari | Kaggle

A simple nn solution with Keras (~0.48611 P 12a776 | Kaggle

Wordbatch FTRL+FM+LGB (LBL 0.42506) | Kaggle

CNN GloVE single model-Private LB 0.41117 (~35th) | Kaggle

Mercari Golf: 0.3875 CV in 75 LOC, 1900 s | Kaggle

上位解法概要

1st place solution: 1st place solution | Kaggle

Pawelさんの解法(チームマージ前、当時暫定2位)

Kostantinさんの解法(チームマージ前、当時暫定1位)

チームマージ時点

最終的なモデル

1. シンプルなMLP

これらのMLPのアイディアを凝縮したkernelが公開されているので是非みていただきたいです。最終モデルに使用したMLPと同じもので、モデルでシンプルさがよく分かると思います。(tkmさんの解説動画もあります)2. 2種類のMLP

3. 3種のデータセット

4. 特徴量の2値化

5. 学習速度のチューニング

6. L2正則化とPRELU

7. tensorflowとMXNetでの実装

2nd place solution: 2nd Place Solution | Kaggle

Ridge回帰

NN

3rd place solution: 3rd solution. 3300s to 0.3905 at public | Kaggle

FM

NN

エポック

バッチサイズ

データ数

学習率

最適化手法

1

907

600k

0.0055

adam

2

907

600k

0.0055

adam

3

1007

600k

0.0055

adam

4

1007

all

0.0055

adam

5

1424

400k

0.0055

adam

6

1424

800k

0.008

adagrad

7

900

women, beauty

0.008

adagrad

その他の上位解法

日本語記事

Kaggleは凄かった! 更に簡単な出品を目指して商品の値段推定精度を改善中 - Mercari Engineering Blog

Kaggle メルカリ価格予想チャレンジの初心者チュートリアル

Kaggle メルカリコンペの優勝コードを眺める動画を作った - tkm2261's blog

【Kaggle】「Mercari Price Suggestion Challenge」に参加したあと、改めて色々調べてみたのでまとめる - St_Hakky’s blog

おわりに

kaggle: Porto Seguro's Safe Driver Prediction まとめ

- はじめに

- コンペ概要

- データの種類とタスク

- 評価方法

- 提出方法

- 勉強になる Kernel と Discussion

- Data Preparation & Exploration | Kaggle

- Stratified KFold+XGBoost+EDA Tutorial(0.281) | Kaggle

- Resampling strategies for imbalanced datasets | Kaggle

- Python target encoding for categorical features | Kaggle

- Dimensionality reduction (PCA, tSNE) | Kaggle

- Tune and compare XGB, LightGBM, RF with Hyperopt | Kaggle

- 2-level Stacker | Kaggle

- Entity Embedding Neural Net | Kaggle

- Gini Coefficient - An Intuitive Explanation | Kaggle

- Big GP | Kaggle

- Kaggle Tutorial on this competition

- 上位解法概要

- 1st place solution: 1st place with representation learning | Kaggle

- 2nd place solution: 三个臭皮匠's approach(s) | Kaggle

- 3nd place solution: 3rd place solution | Kaggle

- その他の上位解法

- 日本語記事

- おわりに

はじめに

過去コンペまとめ記事の二作目です。タイトルにもあるように今回は2017年9月にkaggleで開催されたPorto Seguro's Safe Driver Predictionをまとめたいと思います。前回はToxic Comment Classification ChallengeというNLPコンペについてまとめたので興味のある方はこちらの記事をご覧ください。他者のアイディアや解法を読んでいるだけで面白いですし勉強になるので、思い返すとここ一週間は過去コンペばかり漁っていたような気がします。飽き性ではありますが今のところは週一本ペースでまとめ記事を書くことを目標にしているのでどうぞよろしくおねがいします。

コンペ概要

Porto Seguro(ブラジル最大の自動車保険および住宅保険会社の一つ)が開催する保険金請求予測コンペです。データは非常にきれいなテーブルデータで、ドメイン知識を含めて特別な知識は必要ありません。

自動車保険加入者が翌年に保険金請求するか否かを予測することは、保険料や保険金を設定する上で非常に重要です。このコンペではドライバーが来年自動車保険に保険金請求をするか否かを予測することを目的としています。

賞金・期間・参加者数などは以下の通りで、参加チームは5169チームと非常に多く人気のコンペであったことがわかります。(実は参加者が多いコンペを狙ってまとめ記事を書いています)

| 賞金 | 期間 | 参加チーム数 | 参加者数 |

|---|---|---|---|

| $12,000 | 2017/09/30 ~ 2017/11/30 | 5,169 | 5,864 |

データの種類とタスク

テーブルデータを用いた2クラス分類問題です。連続変数・カテゴリ変数・バイナリ変数で構成されており目的変数も2値なので、よくあるデータ形式だと思います。データサイズが小さい、タスクは2クラス分類と一般的、データがきれいなどの理由から初学者にも取り組みやすいことが人気につながったのかもしれません。 正例データのサンプル数が少ない不均衡データで、目的変数の分布は下図のとおりです。画像は後ほど紹介しますが、ここから拝借しました。

不均衡データの扱いは少し厄介ですが、これも良くあるケースだと思います。

データサイズは以下の通りで、テーブル数は2つでサイズも小さめです。

| ファイル名 | データサイズ | レコード数 | カラム数 |

|---|---|---|---|

| train.csv | 100M | 595,212 | 59 |

| test.csv | 164M | 892,816 | 58 |

ちなみにtrain.csvのheadはこんな感じです。(カラム数が多いので適当に選びました)

連続変数とカテゴリ変数の両方があり、カラム名から変数の意味はわかりません。

カラムは大きく4つに別れており、それぞれ ind(18種)、reg(3種)、car(16種)、calc(20種)の計57種類です。各カラムの意味は公開されていないため、データの意味や傾向は集計やモデリングを通じて理解していく必要がります。(一応、型の情報としてbinはバイナリ変数、catはカテゴリ変数であることは周知されていました)

評価方法

評価指標は標準化ジニ係数(Normalized Gini Coefficient)です。 標準化ジニ係数は0〜1の値を取る評価指標で1に近いほど良いです。 この指標の直感的理解にはこちらのkernelが役立ちます。一応、コンペ概要ページにも簡単な説明があります。

提出方法

提出のフォーマットは以下のとおりです。idごとに保険金請求する確率を以下のように出力します。

| id | target |

|---|---|

| 0 | 0.1 |

| 1 | 0.9 |

| 2 | 1.0 |

勉強になる Kernel と Discussion

上位解法ほどのスコアは出せませんが、kernelとdiscussionは良いアイディアと実装で溢れています。どのアプローチも勉強になったので簡単にまとめておきます。

最後に紹介しているtkmさんのyoutube動画は、これからkaggleを始めたい方にとてもおすすめです。

Data Preparation & Exploration | Kaggle

データの確認、特徴量抽出、特徴量選択、特徴量のスケーリングまでが簡単にまとめられています。以降の解法を読むにあたって簡単にデータを確認しておきたい方には見ておくことをおすすめします。特徴抽出ではカテゴリ変数をダミー化することに加えて、sklearnのPolynomialFeaturesで変数間の相互作用を表現しています。また特徴量選択ではsklearnのVarianceThresholdやSelectFromModelを用いた方法が紹介されており、とても参考になります。

Stratified KFold+XGBoost+EDA Tutorial(0.281) | Kaggle

xgboostによるモデリングが紹介されています。特徴量抽出やモデリング自体に特に工夫は見られませんが、モデリングする上で必要最小限のコードでテーブルデータコンペ初学者におすすめです。

Resampling strategies for imbalanced datasets | Kaggle

不均衡データの対処法であるunder samplingとover samplingについてまとめられています。pandasの基本メソッドで実装できるものから、不均衡データ処理用のライブラリであるimbalanced learnを用いた手法まで図を用いて直感的に説明されています。特にimbalaned learnを用いたunder sampling(Tomek linksとCluster Centroids)やover sampling(SMOTE)の説明はあまり目にしないため非常に参考になりました。kernelの最後にはおすすめの文献も紹介されており個人的にお気に入りのkernelです。

Python target encoding for categorical features | Kaggle

target encodingの実装と評価が紹介されています。target encodingの実装は単純に目的変数の平均値を求めるのではなく、smoothingやnoise機能が考慮されていて非常に勉強になりました。kernelの評価実験をみると今回はtarget encodingが有効であることがわかります。

Dimensionality reduction (PCA, tSNE) | Kaggle

PCAとtSNEを用いた次元圧縮と可視化が紹介されています。手法の説明はありませんが図が多く考察部分の説明が丁寧なので、初学者でも十分理解できると思います。前処理の有無による結果の違いも紹介されていて参考になりました。今回のデータセットは正例・負例の分離が難しいことを結果から確認できます。それからtoy dataに対するtSNEの挙動についてはこちらのdiscussionで紹介されています。

Tune and compare XGB, LightGBM, RF with Hyperopt | Kaggle

hyperoptを用いたrandam forest, xgboost, lightgbmのパラメータチューニングが紹介されています。最適化手法の説明は無く、探索するパラメータも少ない(実用するには探索項目が少ない)ためこれだけ真似しても使いこなせるかどうか怪しいところですが、サンプルスクリプトがまとめられている点で有用だと思います。(RF, xgboost, lightgbmでデータの渡し方が微妙に異なるので)最近では同じくハイパーパラメータチューニングに使用するoptunaというライブラリが公開されているので、興味がある方は本記事の後半で紹介する日本語の記事を御覧ください。

2-level Stacker | Kaggle

シルバーメダル相当のstackingモデルのスクリプトです。このkernelはコンペ終了後に公開されたそうでスコアも良い非常に強力なkernelです。カテゴリ変数をダミー化した後、lightgbm×3, LogisticRegression×2, ExtraTreesClassifier×2, MLPClassifier×1のアンサンブルをしており、その実装は Ensembleクラスにまとめられています。Ensembleクラスはbase_models, stacker_1, stacker2の3層(数え方が分かりませんがここでは3層ということで)のstackingが実装されており、stacker_1の学習はmode引数で2種類の方法を選択できます。stackingのアイディアを知っている方なら実装もすぐに読めると思うので気になる方は是非読んでみてください。個人的に最も勉強になったkernelです。

Entity Embedding Neural Net | Kaggle

kerasを使ったentity embeddingの実装です。カテゴリ変数ごとembedding layerでカテゴリをベクトル表現したものと量的変数にDenseを通したものを全てconcateして、後段のDenseとdropoutにつなげています。本コンペの2nd solutionと似た解法です。ちなみに、Rossmannコンペの3rd place solutionで紹介されており論文も公開されています。

Gini Coefficient - An Intuitive Explanation | Kaggle

今回コンペの評価指標である標準化ジニ係数とジニ係数を簡単な数値例を交えて紹介しています。

Big GP | Kaggle

Genetic Programmingで作成した特徴量を使用したkernelです。はじめてGPの特徴量を見たときは「これが黒魔術か...!!」と驚いた記憶があります。kernelには特徴量作成ロジックについての言及はありませんが、upuraさんが以前ブログに書いていたので実装に興味のある方はこちらを参考にすると良さそうです。

Kaggle Tutorial on this competition

tkmさんのkaggle 入門動画が共有されています。動画ではPorto Seguroコンペの概要、分析環境構築(GCP登録、Ubuntu設定、データ読込)、モデリング(ロジスティック回帰、Cross Validation、Grid Search、xgboost)、submit方法などがわかりやすくデモ形式で紹介されています。私はこの動画のおかげでkaggleに入門することができたのでとても感謝しています。

この他にも、BigQueryでkaggle入門動画がyoutubeに上がっています。こちらはPorto Seguroコンペと直接関係はないのですが、私がBigQueryを使うきっかけとなった動画で「BigQuery気になってるけど、まだ使ったことない」という方にとてもオススメです。

個人的にとてもお世話になった動画たちなので目立つリンクを貼っておきます。

上位解法概要

上位解法はLightGBMとNNのアンサンブル解法が目立ちます。テーブルコンペの定石であるLightGBMにモデルの多様性を意識したNNモデルを用意できるかが一つポイントだったのかもしれません。NNのモデリングに関しては1st ~ 3rdで全く解法が異なっているため読んでいて楽しかったです。今回も1st ~ 3rdまでの解法をまとめたいと思います。

1st place solution: 1st place with representation learning | Kaggle

使用したモデルはLightGBM×1, NN×5(これとは別に特徴量抽出用にNN×5)で各モデルのパラメータ設定は表のとおりです。全てのモデルで準備する特徴量は同じ(表のf0)で、予測モデルがNNの場合は前段にDAE(Denosing autoencoder)による特徴量抽出をしています。予測時には6つのモデルの平均値を求めたそうです。

DAEで表現学習をする前に、最低限の加工としてcalc系のカラムを全て除外し、カテゴリ変数をダミー化しています。(特徴量抽出が好きじゃないので特徴量抽出は基本的にNNに任せたらしい) DAEのノイズはswap noiseで一定の確率で別レコードの値で入れ替えることでノイズとしたそうです。(画像データのようにflip, rotateなどはできず、gaussian, uniform noiseも不適切と考えたため) またスケーリングはRankGaussを使用したそうです。RankGaussの説明はこのサイトが参考になります。DAEの学習にはtrainとtestの両方を使用しており、testが多かったことは好都合だったとのこと。ただしprivate LB scoreにはあまり効果がなかったようです。

2nd place solution: 三个臭皮匠's approach(s) | Kaggle

public5位からshake upにより2位入賞。localCVとpublicのスコアが一致していたため shake up は予想外だったとのこと。trust CVで、localCVの結果が改善された時だけsubmitしていたそうです。 コメント欄を含めると他のチームメンバーの解法も共有されていますが、ここではチームリーダーのLittle Boatさん解法をまとめます。LightGBMとNNのモデルを作成したようです。(どちらもkernelでスクリプトが吸収されているので詳細を知りたい方はそちらも是非)

LightGBM: 2nd Place Lightgbm Solution | Kaggle

以下の特徴量を追加して予測を行ったようです。

- 各レコードの欠損数

- カテゴリ変数をOne Hot encoding

- ind系特徴量を全て連結しカテゴリ変数とする

- カテゴリ変数のカウント情報

NN: 2nd place solution NN model | Kaggle

以下の特徴量を追加して予測を行ったようです。

- 各レコードの欠損数

- 変数の相互作用項(効果的だったもののみ)

- ind、reg, car系特徴量を全て文字列で連結しカテゴリ変数とする

- 特徴量を3グループに分割しxgboostで2グループを説明変数、1グループを目的変数として学習した後、予測値を特徴量として追加

- カテゴリ変数のカウント情報追加

- 2つの特徴量を用いて一方をグループのキーに、一方を集計対象とみなして基本統計量(mean, std, max, min, median)を算出(有効だった組合せのみ)

モデルの構造は、各カテゴリを6次元にembeddingしたものと量的変数をconcateした後に、Dense(512) -> PReLU -> BN -> Dropout(0.75) -> Dense(64) -> PReLU -> BN -> Dropout(0.5) -> Dense(1) するというもの。スケーリングには StandardScalerを使用していました。

3nd place solution: 3rd place solution | Kaggle

public1074位からshake upで3位入賞した解法です。shake upを狙っていたそうですが本人もさすがに驚いたようです。

モデルはlightgbm×1とNN×1のアンサンブルと非常にシンプルで、正直モデルの強みや特徴がどこにあるのかよくわかりませんでした。モデリングの特徴を箇条書きでまとめます。

- calc系のカラムを除外し、LightGBMのCV scoreを確認しながら他にも9つのカラムを除外する

- カテゴリ変数をOne Hot Encoding

- LightGBMのパイパーパラメータは表現力を抑える(lambda_l1=10, num_leaves=24など)

- NNは3層で Dense(4096) _> Dropout(0.5) -> Dense(1024) -> Dropout(0.5) -> Dense(256) で、ネットワーク構造はあまり重要ではなかったとのこと

その他の上位解法

discussionは解法の宝庫ですね。余力がある方はこちらもぜひ。

日本語記事

Kaggleで世界11位になったデータ解析手法〜Sansan高際睦起の模範コードに学ぶ - エンジニアHub|若手Webエンジニアのキャリアを考える!

株式会社Sansanのデータサイエンティストが、Port Seguroコンペを題材に前処理・特徴量抽出・予測モデルについて紹介しています。コードや考え方を初心者でわかるようにQ&A形式で説明されていてわかりやすいです。

世界一のデータサイエンティストを目指して 〜Kaggle参加レポート〜 - Kysmo’s Tech Blog

株式会社キスモの役員の方がPort Seguroコンペの参加記録を書いています。こちらもQ&A形式で説明されていて非常にわかりやすいです。

OptunaとLightGBMを使って、Kaggle過去コンペにsubmitする | Enigmo Life

Port Seguroコンペのデータを使ってOptunaでLightGBMのパラメータチューニングをしている記事です。

おわりに

今回はPort Seguroコンペについてまとめました。テーブルコンペでもNNが積極的に使用されていることは驚きでした。一方でNNのモデリングは1st ~ 3rdで全く異なることから察するに、NNの定石はまだできていないのかもしれません。他のコンペの解法も眺めながら傾向を掴んでいきたいです。次回はメルカリコンペかAvitoあたりをまとめるつもりですのでそちらも読んでいただけると励みになります。

kaggle: Toxic Comment Classification Challenge まとめ

- はじめに

- コンペ概要

- データの種類とタスク

- 評価方法

- 提出方法

- 勉強になるkernelとdiscussion

- Stop the S@#$ - Toxic Comments EDA | Kaggle

- NB-SVM strong linear baseline | Kaggle

- Logistic regression with words and char n-grams | Kaggle

- LightGBM with Select K Best on TFIDF | Kaggle

- Wordbatch 1.3.3 FM_FTRL LB 0.9812 | Kaggle

- [For Beginners] Tackling Toxic Using Keras | Kaggle

- Improved LSTM baseline: GloVe + dropout | Kaggle

- Capsule net with GRU | Kaggle

- A simple technique for extending dataset | Kaggle

- 上位解法概要

- 1st place solution: 1st place solution overview | Kaggle

- 2nd place solution: 2nd place solution overview | Kaggle

- 3rd place solution: About my 0.9872 single model | Kaggle

- その他の上位解法

- おわりに

はじめに

過去コンペまとめ記事の一作目です。タイトルにもあるように今回は2017年12月にkaggleで開催された Toxic Comment Classification Challenge(以下、Toxicコンペ) をまとめたいと思います。 kaggleの楽しみ方として実際にコンペに参加してスコアを競うのも一つですが、過去コンペの解法を眺めているだけでも十分にkaggleを楽しめますし、何より勉強になるのでおすすめです。 今後も気になったコンペから順にまとめ記事を書いていくつもりですので、どうぞよろしくおねがいします。

コンペ概要

Toxicコンペは、JigsawとGoogleが創設したConversation AIチームが主催の 有害なコメントへのタグ付けコンペ です。データはWikipediaのtalk pageのコメントでNLPの知識が求められます。

Wikipediaは誰でも編集可能なインターネット百科事典ですが、各ページには利用者が質問や議論を行うためのtalk pageが用意されています。talk pageで利用者がページの改善について意見交換することでページの質を高めているというわけです。質問や議論では相手に敬意を払うことが大切ですが、なかには有害なコメントもあるようで、Toxicコンペの目的はそれらの有害なコメントを分類することです。

賞金・期間・参加者数などは以下の通りで、参加チームは4551チームと非常に多く人気のコンペであったことがわかります。

| 賞金 | 期間 | 参加チーム数 | 参加者数 |

|---|---|---|---|

| $18,000 | 2017/12/20 ~ 2018/03/21 | 4,551 | 93,435 |

データの種類とタスク

テキストデータを用いた 多ラベル分類問題(Multilabel classification) です。各クラスの所属確率を出力するモデルを構築する必要があります。ただし多クラス分類問題(Multiclass classification)とは異なり、一つのサンプルが複数のクラスに属する可能性があります。クラスは6種類(toxic, severe_toxic, obscene, threat, insult, identity_hate) で、下図のようにclass imbalance かつ mulitlabel といった特徴があります。画像は後ほど紹介しますが、この EDA kernelから拝借しました。

データサイズは以下のとおりです。NLPコンペではありますが データが小さい ため、比較的参加しやすいコンペだったのだと思います。

| ファイル名 | データサイズ | レコード数 | カラム数 |

|---|---|---|---|

| train.csv | 68.8M | 159,571 | 8 |

| test.csv | 68.4M | 153,164 | 2 |

ちなみにtrain.csvのheadはこんな感じです。 コメント毎にIDとクラスラベル が与えられています。

試しにtoxicクラスのサンプルをいくつか見てみると、例えばこんなものがありました。

Bye! Don’t look, come or think of comming back! Tosser.

FUCK YOU U USELESS BOT FUCK YOU U USELESS BOT FUCK YOU U USELESS BOT (以下繰り返し)

DELETE!?!?!? You delete vandalist pages?!?!?! You sick, sick bitch.

なんだか治安が悪いですね。英語が苦手な私でもきれいな言葉ではないことくらいはわかります。勿論toxicクラスのサンプル自体が全体で見ると少ないため、このような文章ばかりではありません。興味のある方は自分の手でデータを確認してみてください。(ちなみにservere_toxicクラスはさらに酷いコメントで溢れています)

評価方法

評価指標には mean columns-wise ROC AUC です。つまりクラスごとに算出したAUCの平均値で評価します。 ちなみに1st solutionは private LBで 0.9885 と非常に高いスコアを記録しています。1.0に近いスコアが出ていることから、タスクとしては簡単だったのかもしれません。

提出方法

提出のフォーマットは6種のクラスそれぞれの所属確率を以下のように出力します。 多クラス分類問題ではないので、各クラスの予測確率の和が1である必要はありません。

| id | toxic | severe_toxic | obscene | threat | insult | identity_hate |

|---|---|---|---|---|---|---|

| 00001cee341fdb12 | 0.5 | 0.5 | 0.5 | 0.5 | 0.5 | 0.5 |

| 0000247867823ef7 | 0.5 | 0.5 | 0.5 | 0.5 | 0.5 | 0.5 |

勉強になるkernelとdiscussion

上位解法ほどのスコアは出せませんが、kernelとdiscussionは良いアイディアと実装で溢れています。どのアプローチも勉強になったので簡単にまとめておきます。

Stop the S@#$ - Toxic Comments EDA | Kaggle

EDA kernelです。データの確認、可視化、集計結果の考察、前処理、基本的な特徴量抽出、モデリングなど初学者には参考になるものばかりだと思います。以降の解法を読む上で一度データを確認しておきたい方は、このEDAを見ることをおすすめします。データの雰囲気が分かり、解法が理解しやすくなるはずです。

NB-SVM strong linear baseline | Kaggle

NBSVM(Naive Bayes - Support Vector Machine)を参考にした(?)解法です。公開kernelの中では最もVoteを稼いでいました。NBSVMの論文へのリンクが貼られていますが、kernelで実装されているものは元論文の手法にいくらかアレンジを加えたものでした。アイディアとしてはベイズの定理を用いて特徴量を抽出した後、SVMで分類するだけなのですが、特徴抽出時に使用する式を少し変えているのとSVMの代わりにロジスティック回帰を使用している箇所が元論文と異なります。

Logistic regression with words and char n-grams | Kaggle

TFIDFで特徴抽出した後、ロジスティック回帰でモデリングしています。私のようなNLP初学者はこのようなシンプルなモデルからはじめると良いのかもしれません。TFIDF特徴を作成する際は sklearnのTfidfVectorizerを使用しています。これを使えばngramの指定や文字単位(word, charなど)の指定が簡単にできるので便利ですね。個人的には analyzer='word', ngram_range=(1, 1)とanalyzer='char', ngram_range=(2, 6) で作成した行列をconcateして特徴量にする部分が勉強になりました。analyzer='char'に設定して特徴量にする方法は覚えておこうと思います。ロジスティック回帰モデルはクラスごとに6つ作成します。multilabel なので2クラス分類モデルをラベルの種類数分用意する必要があるようです。欠点としてはクラスの共起性をモデルに組み込みにくいことでしょうか。

LightGBM with Select K Best on TFIDF | Kaggle

TFIDFで特徴量抽出した後、LightGBMでモデリングしています。さきほどの解法のロジスティック回帰部分をLightGBMに変えています。

Wordbatch 1.3.3 FM_FTRL LB 0.9812 | Kaggle

TFIDFと集計ベースの特徴量生成した後、FM_FTRL(FTRLの関数をFMとしたアルゴリズム、私もあまりわかってません)でモデリングしています。実装にはwordbatch(kagglerが作った文章特徴抽出ライブラリ)を使用しています。(wordbatchは所見だったので勉強になりました。)集計ベースの特徴量には文字数、単語数、大文字数、リンク数、メールアドレス数など一つ一つ作成しています。こういう特徴量生成を見るとkaggle感があって良いですね。気になる方はコードを読んでみてください。

[For Beginners] Tackling Toxic Using Keras | Kaggle

kerasを使ったLSTMのtutorialです。文章の前処理(Tokenization -> Index Representation)、Embedding, LSTM, GrobalMaxPool, dropout などの役割と実装が丁寧に説明されています。NNでNLPをはじめてみたい方におすすめできるkernelです。

Improved LSTM baseline: GloVe + dropout | Kaggle

GloVeとLSTMを用いたNN解法です。NN解法の多くはWord2vec, GloVe, fastTextなどで単語をベクトル表現した後、BidirectionalのLSTMやGRUを通し、Denseに繋げているようです。このkernelではGloVe -> Bi-LSTM -> GlobalMaxPool1D -> Dense -> dropout -> Dense のNNを作成しています。

Capsule net with GRU | Kaggle

Gapsule Netを実装しています。Capsule Netとは一般的なNNのニューロン(入出力がスカラー)を入出力がベクトルのCapsuleという構造に一部置き換えたネットワークだそうです。(よく知らないので勉強します。)コードを拝借して近々動かしてみようと思います。

A simple technique for extending dataset | Kaggle

翻訳を利用した augmentation について紹介されています。翻訳による変換を2回行うことでデータの水増しをねらいます。具体的には、英語 -> ドイツ語 -> 英語、英語 -> フランス語 -> 英語、英語 -> スペイン語 -> 英語 といった具合に変換します。変換前と変換後の文章では単語や言い回しが微妙に異なるためデータの水増しが可能です。

上位解法概要

上位解法はembeddingとRNNを用いたNN解法 が目立ちます。 kernelを見るとロジスティック回帰、NBSVM、LightGBMなどの手法も多く見られましたが、NNを使わずに上位を目指すことは難しかったようです。NLPといえばNNが定石の時代になりつつあるのでしょうか。(よく知らない) discussionには上位解法がいくつか共有されていますが、今回は 1st ~ 3rd solutionのみまとめました。

1st place solution: 1st place solution overview | Kaggle

解法の要点は以下の4つです。

- 様々な学習済みのembedding手法 (baseline public LB of 0.9877)

- 翻訳によるデータの水増し (Translations as train/test-time augmentation) (boosted LB from 0.9877 to 0.9880)

- pseudo-labeling (boosted LB from 0.9880 to 0.9885)

- Robust CV + stacking framework (boosted LB from 0.9885 to 0.9890)

1. 様々な学習済みの embedding 手法

今回のタスクでは embedding layer が重要であると判断して、embedding layerのチューニングに集中したそうです。それ以降の構造は Bi-GRU と Dense×2 なのでkernelの解法とあまり違いがないように思えます。注目のembeddingですが、Common Crawl, Wikipedia, Twitterのデータで学習済みのfastTextとGloVeを使用したようです。

2. 翻訳によるデータの水増し

train/testの両方で翻訳によるaugmentationをしたそうです。(英語 -> ドイツ語 -> 英語と変換するやつ)ドイツ語、フランス語、スペイン語で実施し精度向上に大きく貢献したそうです。train-val split時にはleak対策のため、同じ文章から作成したサンプルは同一セットにまとめるよう注意します。少し細かいですがこの手のテクニックは実務でもコンペでも重要だと思うので知っておくと良さそうです。予測時には4つのコメント(オリジナルとフランス語、ドイツ語、スペイン語を経由したもの)の平均をとります。(ここもしかしたら読み間違えているかも。言語ごとにモデルを作っている可能性もある...??)

3. pseudo-labeling

標準的なものからLossを変えたものなど、いくつかのpseudo labelingを試したそうです。最も効果的だったのは標準的なもの(test sampleに予測値を付与し、それをtrainに加えた上で再度学習する)だったそうです。今回のタスクはスコアが0.98以上と非常に高く、疑似ラベルの信頼性が高かったことも影響しているのかもしれません。コメントにはスコアがそこそこのタスクで同様のことを試した際にはうまくいかなかったという経験談もありました。

ちなみにコメント欄でpocketさんがわかりやすい図を共有していたので貼り付けておきます。lossを全てlog lossに設定すること以外はこの理解で間違いないようです。

4. Robust CV + stacking framework

stackingにはベイズ最適化でゴリゴリチューニングしたLightGBMを使用し、単体モデルよりも~0.001程度スコアを向上したそうです。LightGBMは深さ浅めでL1ノルム強めにすると良かったとのこと。ブレを抑えるべくseedを変えたDARTとGBDTをそれぞれ6つ学習してバギングしたようです。次にCVについてですが、CVスコアとしては accuracy, log loss, AUCを確認していたそうです。モデルを採用するかはstackingに加えた際に、CV-logloss, CV-AUC, public LBの全てが改善されているか否かで判断します。多くのモデルを捨てることになりますが、overfittingを避けるためにこうしたとのこと。指標を複数用意してTrust CVしていたのですね。

その他に試したこと

上記4つは特に効果的だったようですが、その他の実験結果についても言及されているので興味がある方はぜひ。

2nd place solution: 2nd place solution overview | Kaggle

モデルの多様性を意識してRNN, DPCNN, GBMを学習させてアンサンブルしたそうです。NNモデルの要点について3つ共有されていました。 最終的に30個のモデルを作成し、予測値の平均をとったそうです。

1. pre-trained embeddings (fastText, GloVe twitter, BPEmb, Word2vec, LexVec)

1位解法に続いて2位解法でもembeddingをいろいろ試しています。私はBPEmb, LexVecは初見だったのでとても参考になりました。embeddingモデルのまとめはこのgitgubにまとまっていたので興味のある方は覗いてみて下さい。BPEmbに関しては275言語に対応しているようです。

2. 翻訳によるデータの水増し

ここも1位解法と同様ですね。詳細は述べられていませんが、ドイツ語、フランス語、スペイン語の翻訳を利用したaugmentationをしたそうです。

3. 多言語に翻訳した上でBPEmbでembedding

英文をドイツ語、フランス語、スペイン語に変換した後(英文に戻すことなく)学習済BPEmbでEmbeddingしたそうです。BPEmbをうまく使用していますね。

3rd place solution: About my 0.9872 single model | Kaggle

3位解法として最良のシングルモデルが共有されていました。使用したのはRNNモデルでモデル構造とパイパーパラメータ、前処理について書かれていたので簡単にまとめます。実装にはkerasを使用したようです。

モデル構造

- 1層目

- 基本的にはfastTextとGloVe twitter embeddingをconcatしたものだそう。単語ベクトルがない単語は"something"に置換したとのこと。加えて、大文字の単語は1, それ以外は0のフラグも特徴量も追加したようです。

- 2層目

- SpatialDropout1d(0.5)

- 3層目、4層目

- カーネルサイズ40のBidirectional CuDNNLSTM

- 5層目

- LSTMのlast state, maximum pool, average poolと別で作成しておいた2つの特徴量(ユニークな単語の割合、大文字単語の割合)をconcate したそうです。NN初心者の私にとっては非常に参考になりました。

- 6層目

- dense

パイパーパラメータと前処理

- batch size: 512. 大きめに設定したほうが結果が安定したそうです。

- Epoch: 15

- Sequence length: 900

- optimizer: Adam with clipped gradient

- 前処理としてUnidecodeライブラリで文章をASCIIに変換した後、文字と句読点以外は除外したそうです。その他にもスペルミスを一生懸命直したところスコアが改善したようです。詳細はdiscussionに書かれているので興味のある方はぜひ。

その他の上位解法

discussionは解法の宝庫ですね。余力がある方はこちらもぜひ。

おわりに

ブログにまとめるまでにそれなりに時間はかかりましたが、NLPの分類タスクの雰囲気がつかめたのは収穫です。上位解法ももちろん勉強になりましたが、個人的にはkernelで多様なアプローチを読むほうが面白いし勉強になると感じたので「kaggleでNLPの勉強してみたいけど、どこから手を付けていいかわからない。」という方は是非kernelを読んでみて下さい。読むだけで学びがありますし、終了したコンペではありますが kernelを真似して、late submission してみるのも面白いかもしれません。

続編はマイペースに書いていこうと思いますが、もしかしたらめんどくさくなるかもしれません。。めんどくさくなってしまったらごめんなさい。

signate 公園コンペ で8位でした。

自己紹介

はじめまして。最近、copypasteとしてtwitter, signate, kaggle を始めたものです。

ブログ執筆にも前々から興味はあったのですが、書くネタが思いつかない&書くのが面倒 という理由で一歩踏み出せずにいました。(「アウトプットは大事!」という話は何度か耳にしましたがどうしても半信半疑..)

ただ、コンペに参加する中で様々なcompetitorさんやengineerさんのブログやtweet(その他にもyoutube, kaggle kernel, 書籍などなど)に助けられたので、少しでも還元できればという気持ちと、頭の整理、備忘録も兼ねてブログデビューを決めました。

今後もデータ分析周りのトピックで何かしら書いていけたらな〜と思っております。よろしくおねがいします。

コンペ概要

コンペのテーマは「国立公園の観光宿泊者数予測」でした。

予測対象は下記8つの国立公園で、公園ごとに1年間(2017-01-01 ~ 2017-12-31)の観光者数を日毎に予測します。

学習データの期間は 2015-01-01 ~ 2016-12-31 なので、2年間のログデータを使用して直近1年間を予測することになります。

- 阿寒摩周国立公園

- 十和田八幡平国立公園

- 日光国立公園

- 伊勢志摩国立公園

- 大山隠岐国立公園

- 阿蘇くじゅう国立公園

- 霧島錦江湾国立公園

- 慶良間諸島国立公園

実用性を重要視した問題設定で、前日以前のデータを元に翌日以降の観光者数を予測するモデルを作る必要がありました。(当たり前といえば当たり前ですが)

要は、kaggle で時折見られる評価データを用いた特徴抽出(train, testをconcatした上で統計量算出など)は禁止されていました。

私としては実問題に近いタスクのほうが取り組む意欲が湧くので、このような問題設定はありがたかったです。

目的変数は公園毎・日毎の観光者数で、評価指標はMAEでした。 公園毎に目的変数の推移や値域が異なっていたので、"公園毎の性質の違いをどうモデルに組み込むか"も一つ重要な点だったのかもしれません。

目的が明確、データの欠損もない、公園毎のサンプル数も均一、データサイズも小さい、ので初学者には取り組みやすいテーマ&データだった印象です。唯一やりにくいと感じたのはサンプル数が若干少ないことくらいでしょうか。(学習セットは公園毎に2年×365日=730サンプル程度)

ちなみに賞金は無く、上位三名には懸賞として国立公園招待券がプレゼントされます。

私は沖縄の公園を満喫するべく、1位目指して毎日公園のことを考え続けました。(初参加&初優勝って誰もが憧れる展開じゃないですか??)

まぁ結果的に大差で負けてしまったわけですが。。

データ概要

データは観光者数のログデータに加えて、以下の外部データが与えられました。

- SNSデータ(株式会社ホットリンク)

- ロケーション付SNSデータ(株式会社ナイトレイ)

- メッシュ型流動人口データ(株式会社Agoop)

- 公共交通検索ログデータ(ジョルダン株式会社)

- 国別月別来訪者数集計データ(株式会社コロプラ)

- 気象データ(気象庁)

- 積雪気象観測データ(防災科学技術研究所(NIED))

- 公共交通検索ログデータ(ジョルダン株式会社)

気象データ(温度、湿度、天気など)や SNSデータもあり、データのリストを見たとき「面白そうだな〜、いろいろ活用方法が考えられそうだな〜」なんて思った記憶があります。(結局一つも使いこなせず、使用しませんでしたが...)

公共交通検索ログデータに至ってはダウンロードすらしておらず、中身すら確認していなかったことにコンペ終了後に気が付きました。

twitter情報によるといくつかの公園では特徴量として有効だったそうで間抜けな自分を恨みます。分析を始める前にしっかりとデータを確認することが大事ですね。。

解法

私の解法を端的に述べると「前年の観光者数を特徴量にしたlightgbm」です。

唯一工夫した点は、とても強引なOver Samplingくらいでしょうか。

取り組んだ順に解法をまとめたいと思います。

public LB: 6000台 [1サブで優勝を狙うも撃沈]

記念すべき最初のサブミットで上位を狙おうとしていました。(1サブで優勝って誰もが憧れる展開じゃないですか??)

結果、しょーもないバグで失敗に終わりました。バグの内容も覚えていません。

そもそも1サブで優勝なんて私にはできるわけないのです。

public LB: 2100台 [ベースラインモデル完成]

バグを修正したところ2100台でした。

モデル構築の方針ですが、私は「前年のログデータから予測日と類似した日付を参照し、類似日の情報を使って予測するモデル」を構築しようと考えました。

具体的には、2017-01-22の予測時には2016-01-22の観光者数を参考にすると良いだろうと考えたわけです。(2016-01-22と2015-01-22は類似していると考える)

この方針でモデル構築するために、サンプルを以下のように準備しました。

- 学習データ

- 2015 -> 2016 (2015年の履歴を参考に、2016年の観光者数を予測)

- サンプル数は365(日)×8(公園数)= 2920になる。

- 評価データ

- 2016 -> 2017 (2016年の履歴を参考に、2017年の観光者数を予測)

このサンプルの作り方だと2015年のデータが準備できず(2014年のデータがないため)、サンプル数が半減する不利益がありますが、今回は類似日の目的変数が特徴量として使用できる利益を重視しました。

次に類似日の定義ですが、今回は以下の項目が一致する日付を類似日とし、項目ごとにgroupbyした基本統計量(頻度、最小、最大、平均、パーセンタイル)由来の特徴量を作成しました。

- 月

- 曜日

- 週数(weekofyear)

- 週末フラグ

- 祝日フラグ

- 休日フラグ

- 最近傍の休日までの日数

- 連休フラグ

- 連休何日目か

- 月×曜日

- 月×週数

- 月×週数

- ....などなど

カレンダー情報の取得にはjpholidayを使いました。

予測時は目的変数に対数スケール変換(np.log1p)をしたほうが良かったです。

あとはLightGBMに突っ込んでおしまい。

LightGBM は MAE を直接最適化できるので便利ですね。

public LB: 1900台 [CV探索]

次に有効なCV探しをしました。

ここまでは特に何も考えずランダムに5-Foldしていたのですが、コンペではCVの切り方が大事と聞いていたのでいくつか試しました。(実務でも勿論大事なわけですが)

以下が試したものです。

- Random Kfold

- Stratified Kfold

- groupに公園を指定

- groupに月を指定

- groupにweekofyearを指定

- groupに公園×weekofyearを指定

結局、weekofyearをgroupにした Repeated Stratified Kfold にしました。5Fold×5ですね。

TimeSeriesSplitについては、1年通してまんべんなく学習させたい気持ちが強かったので試しませんでした。(groupに月を指定したStratified Kfoldがうまく行かなかったことも理由の一つ)

CVを変えただけでもスコアが伸びたので、データの渡し方の重要さを学びました。 (納得いくCVは結局作れなかったのですが...)

public LB: 1700~1800台 [特徴量探索]

過去の目的変数の集計値が有効なら、それを加工したデータの集計値も有効だろうと考えました。

具体的には移動平均や季節性の排除などをして、時系列データを加工しました。

加工した後は、これまでと同様に基本統計量由来の特徴量を作成します。

- 移動統計量(平均、最小、最大、標準偏差):3日、7日

- 実測値/(移動平均+1) (+1することでゼロ乗算を回避)

- 公園毎に標準化

- さらにごにょごにょして公園毎の日別の注目度を出そうとしたりもしました。

- 季節性の排除(statsmodels, prophet)

- statsmodelsを使用

- prophetを使用

さらに、364,365,366日のラグ特徴量も追加しました。

public LB: 1600 ~ 1700台 [Over samplingに挑戦]

サンプル数が少ないことが気になったので、Over Samplingしました。

かなり強引ですが時系列を無視して、サンプルを水増ししました。

試した組み合わせは色々です。

2015.5年は2015年と2016年の中点をとって作成しました。

- 2016 -> 2015

- 2015 -> 2015.5

- 2015.5 -> 2016

- 2015.5 -> 2015

- 2016 -> 2015.5

- ....(2015.2や2015.7など作って試行錯誤)

結局、日光以外の7公園は 2015->2016, 2016->2015, 2015.5->2016で学習し、日光は2015->2016, 2015.5->2016で学習しました。

日光を別にモデリングした理由は、日光だけ2015年と2016年で目的変数の分布が異なっていたためです。

2015年から2016年にかけて増加傾向が見られたためか、逆向きのOver Samplingは逆効果でした。

public LB: 1500台 [各種パラメータ調整]

特徴量選択やLightGBMのハイパラチューニングなどしました。

ちょうどoptunaが公開された時期だったので少し試してみましたが、結局手動チューニングが一番よかったです。

kaggle kernelからLGBMのパラメータを拝借して微調整するだけで十分でした。

optunaの使い方が悪かっただけかも(ほとんど枝刈りしていて全然探索してもらえませんでした。)

最終結果

最終スコアは public LB:1583.5, pribete: 1827.9 でした。

1位の方は puplic: 1371.6 pribate:1585.2 なので public, pribate共に大敗です。

その他に試したこと

- 公園毎にモデル構築

- 天気を考慮した時系列加工(台風などを考慮したかった)

- ノイズを加えたOver Sampling

- stacking

- 公園ごとに学習サンプルに重み付け

試してみたかったこと

- 時系列データ用の特徴抽出ライブラリ

- 外部データの使用

- 3カラムのデータだけでも試したいことが沢山あったので外部データにあまり目が行きませんでした。

他の方の解法

実際に取り組んだコンペの別解法はとても勉強になります。

2つともサンプル作成方法から私と異なっていて驚きました。

kaggleのようにチームが組めたなら、このようなモデルとアンサンブルすると良いのかもしれませんね。

自分にはなかったアイディアが多くあるので次に活かそうと思います。

- upuraさん

- ktrさん

おわりに

はじめてコンペを完走できて嬉しい反面、悔しい気持ちも強いです。

自分の立ち位置が少しわかった気がするので、次はさらに上位を目指して頑張ろうと思います。

最後にブログデビューの後押しをしてくださったupuraさんに感謝申し上げます。

次回はkaggleについて何か書けたらな〜と思っております。

アウトプットの大事さを肌で感じられると良いな〜